Willkommen zu unserem neuen Beitrag in der Spotlight-Serie! In dieser Reihe beantworten unsere Expert*innen die häufigsten Fragen zu spannenden Tech-Themen. Heute wollen wir in die neue Welt der generativen künstlichen Intelligenz (GenAI) eintauchen. In einem Kurzabriss erkläre ich, was generative KI ist, wie sie funktioniert und welche Einsatzmöglichkeiten es gibt.

Für alle Themen, die eine tiefere Einführung benötigen, verlinke ich spezielle Suchprompts für die AI-Suchmaschine Perplexity.ai, die das Thema tiefergehend erläutern. Auf den Ergebnisseiten findest du weitere Links, mit denen du endlos zu dem Thema recherchieren kannst.

Was ist generative künstliche Intelligenz resp. GenAI eigentlich?

Generative KI (GenAI) ist ein spezialisierter Teilbereich der künstlichen Intelligenz, der sich mit der autonomer Erzeugung neuer Inhalte beschäftigt. Dazu zählen Texte (z. B. ChatGPT), Bilder (z. B. DALL-E, Midjourney), Musik (z. B. suno.ai) oder Videos (z. B. Runway ML, Synthesia). Zu Beginn lag der Schwerpunkt hauptsächlich auf der Textgenerierung auf Basis eines Eingabetextes, wie man es von traditionellen Chatbots kennt. (Die vielseitigen Möglichkeiten, die moderne intelligente Chatbots bieten, werden am Beispiel des Chatbots unseres Partners Mercury deutlich.)

Mittlerweile sind jedoch zahlreiche Variationen und Anwendungen möglich:

Text-to-Text: Hierbei handelt es sich um die Übersetzung zwischen Sprachen, die Zusammenfassung längerer Texte sowie die Beantwortung von Fragen.

Text-to-Code: Diese Anwendung ermöglicht die Erstellung einfacher Programme aus Beschreibungen und die Umwandlung von Pseudocode in echten Code.

Text-to-Image: Hierunter wird die Erzeugung von Bildern basierend auf textuellen Beschreibungen verstanden.

Text-to-Speech: Diese Funktion beinhaltet Vorlesefunktionen für digitale Texte sowie die Vertonung von Podcasts.

Text-to-Video: Diese Methode befasst sich mit der Erzeugung von Videos aus textuellen Beschreibungen.

Image-to-Image: Hierbei geht es um Stilübertragungen zwischen Bildern sowie das Entfernen oder Hinzufügen von Objekten in Bildern.

Image-to-Text: Hier geht es um die Inhaltsanalyse von Bildern, sowie die Datenextraktion.

Image-to-Video: Diese Funktion ermöglicht z.B. die Erzeugung von Videoanimationen basierend auf einem Einzelbild.

Video-to-Text: Hier geht es um die Extraktion von Informationen aus Videos in textlicher Form.

Video-to-Video: Diese Anwendung behandelt die Stilübertragung zwischen Videos sowie ebenso das Entfernen oder Hinzufügen von Objekten in Videos.

Speech-to-Text: Hierbei handelt es sich um die Sprachsteuerung von Geräten sowie die Transkription von Sprachaufnahmen oder Live-Sendungen.

Speech-to-Speech: Diese Methode umfasst z.B. die Echtzeit-Übersetzung und Sprachverarbeitung in Form von Stimmantworten.

Text-to-Musik: Hier geht es um die Erzeugung von Songs aus textuellen Beschreibungen.

Die Vielzahl dieser Varianten zeigt, wie unterschiedlich Generative KI eingesetzt werden kann und unterstreicht das enorme Potenzial dieser Technologien in verschiedenen kreativen und praktischen Anwendungsbereichen.

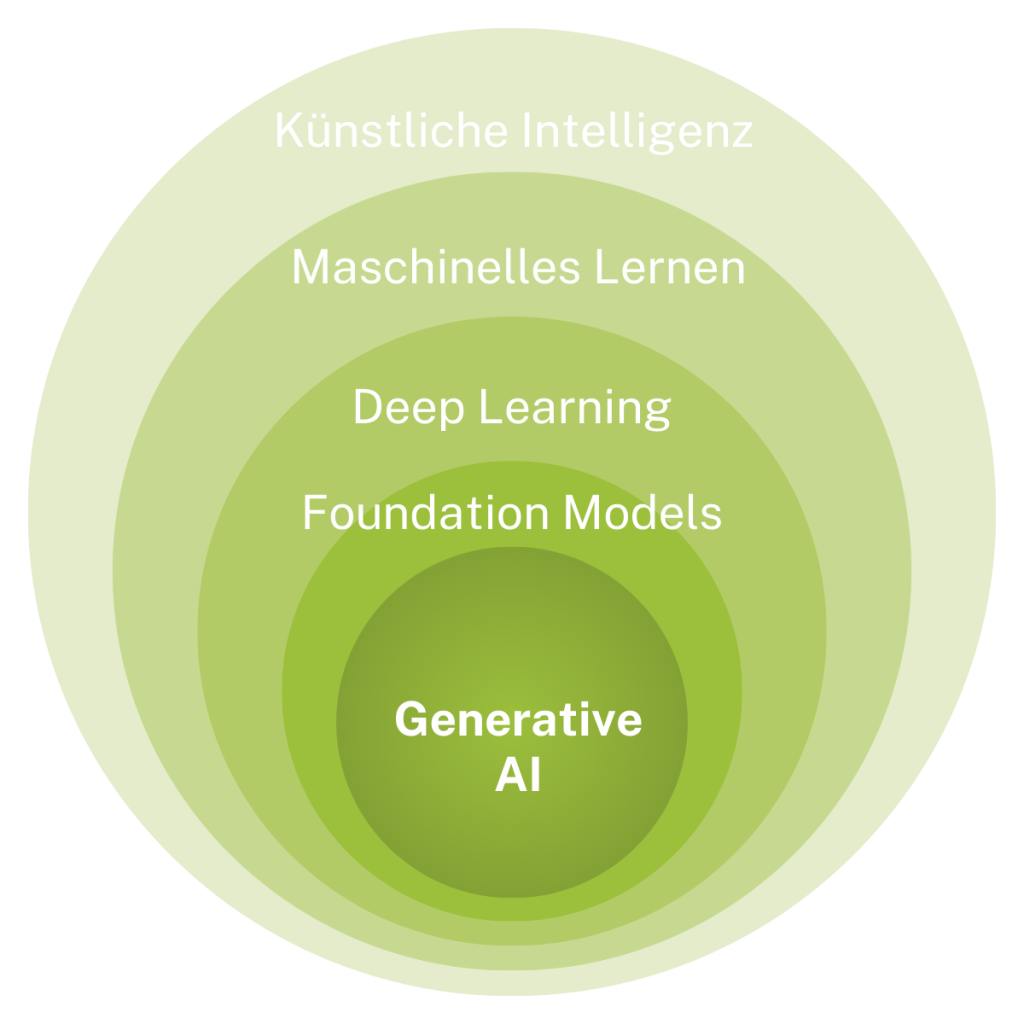

Wo ist GenAI im Bereich der künstlichen Intelligenz angesiedelt?

Innerhalb der künstlichen Intelligenz könnte man den Bereich GenAI in einem Venn-Diagramm etwa so verorten:

Künstliche Intelligenz (KI) ist das umfassende Feld, das alle anderen Konzepte umschließt.

Es umschließt Maschinelles Lernen (ML), das sich darauf konzentriert, Systeme zu entwickeln, die aus Daten lernen und sich verbessern können. (mehr Informationen)

Deep Learning (DL) ist ein spezialisierter Bereich des maschinellen Lernens, der auf neuronalen Netzen basiert und besonders für die Verarbeitung großer Datenmengen geeignet ist. Teilelement von DL sind die Foundation Models, welche großskalige neuronale Netze sind, die für eine Vielzahl von Aufgaben trainiert werden und als Grundlage für spezifische Anwendungen dienen können. (mehr Informationen)

Der Unterbereich von den Foundation-Models, großen vortrainierten Fundament-Modellen, ist nun GenAI, das Thema, mit dem wir uns hier tiefergehend befassen. Möchtest du mehr zu den anderen Teilelementen erfahren, dann findest du hier weitere Informationen dazu.

Auf welcher Technologie basiert GenAI?

Ein zentraler Bestandteil von generativer künstlicher Intelligenz sind neuronale Netze, die ähnlich wie das menschliche Gehirn funktionieren. Diese Modelle bestehen aus „Neuronen“, die Informationen weitergeben und helfen, Muster zu erkennen und Vorhersagen zu treffen. Man kann sich das wie ein Netzwerk aus Lichtern vorstellen, das sich aktiviert, wenn ein Bild oder Satz eingegeben wird, um die beste Antwort zu finden. (mehr Informationen)

Bei Chatbots wie ChatGPT kommen spezielle neuronale Netze, sogenannte Large Language Models (LLMs), zum Einsatz, die für die Verarbeitung von Text entwickelt wurden. Sie funktionieren ähnlich einem Wortgenerator, der auf Fragen und Anfragen reagiert. Um das Modell zu trainieren, wird es mit einer großen Menge an Textdaten gefüttert, was seine Fähigkeit zur Mustererkennung verbessert. Beim Generieren neuen Textes analysiert das Modell den Ausgangstext und wählt das wahrscheinlichste nächste Wort aus, bis der gewünschte Textabschnitt erreicht ist. (mehr Informationen)

Das GPT in ChatGPT steht für Generative Pre-trained Transformer, eine spezielle Architektur, die kontextuelle Bedeutung besser erkennt. Dies erfolgt durch die „Self-Attention“-Methode, welche es ermöglicht, relevante Wörter im Satz zu identifizieren und deren Wichtigkeit zu gewichten. Das verbessert das Verständnis der Bedeutung im Kontext erheblich und erhöht die Effizienz durch gleichzeitige Verarbeitung der Eingabe. Die Leistung dieser Transformer-Modelle steigert sich mit der Menge an verfügbaren Daten. (mehr Informationen)

Der Transformer ist theoretisch wie eine Person, die in der Lage ist, gleichzeitig an mehreren Teilen des Puzzles zu arbeiten und immer die besten Verbindungen zwischen den Teilen zu erkennen. Egal, wie viele Teile oder Farben es gibt, die Person kann den Überblick behalten und das Bild schneller und klarer zusammensetzen. Der Transformer macht das halt mit Wörtern und Sätzen.

Wegen dieser vielfältigen Vorteile sind heutige LLMs meistens transformatorbasiert.

Was ist Prompting und wie macht man das?

Prompting bezeichnet die Methode, eine KI anzuweisen, Aufgaben auszuführen oder Informationen bereitzustellen. Durch spezifische Anweisungen oder Fragen, kurz „Prompts“, beeinflussen wir die Reaktion der KI. Es gibt verschiedene Ansätze des Promptings:

Zero-Shot Prompting erfolgt, wenn du eine Frage stellst und eine Antwort erwartest, ohne der KI zusätzliche Infos zu geben. Dies setzt voraus, dass die KI bereits Kenntnisse über das Thema hat. (mehr Informationen)

Erkläre den Unterschied zwischen Photosynthese und Zellatmung.

Few-Shot Prompting hingegen bietet der KI Beispiele zur besseren Verständnis. Dies hilft der KI, deine Anfrage nach weiteren Beispielen für Haustiere gezielter zu erkennen. (mehr Informationen)

Hier sind zwei Beispiele für Zusammenfassungen von Filmen:

Star Wars: Ein junger Held schließt sich Rebellen an, um ein böses Imperium zu bekämpfen und entdeckt dabei seine Macht.

Titanic: Eine verbotene Romanze entsteht auf einem zum Untergang verdammten Luxusdampfer.

Fasse nun den Film 'Der Herr der Ringe' in einem ähnlichen Stil zusammen.

Chain-of-Thought Prompting bittet die KI, ihre Denkvorgänge offen darzulegen. Dies fördert ein besseres Verständnis der Logik. (mehr Informationen)

Ein Apfelbaum produziert jährlich 300 Äpfel.

Der Bauer verkauft 80% davon auf dem Markt für 0,50€ pro Apfel.

15% werden zu Apfelsaft verarbeitet, der für 2€ pro Liter verkauft wird (1 Liter Saft benötigt 5 Äpfel).

Der Rest wird verschenkt.

Wie viel Gewinn macht der Bauer insgesamt?

Bitte erkläre deine Berechnungen Schritt für Schritt.

Automatic Chain-of-Thought (Auto-CoT) automatisiert den Prozess von Chain-of-Thought, sodass die KI eigenständig Denkschritte generiert und konsistentere Antworten liefert, ohne wiederholte Aufforderungen. (mehr Informationen)

Ich werde dir eine komplexe Frage stellen. Bitte analysiere die Frage, zerlege sie in Teilschritte und beantworte dann jeden Teilschritt, bevor du eine Gesamtantwort gibst.

Frage: Wie würde sich eine Verdoppelung des atmosphärischen CO2-Gehalts auf das globale Klima auswirken?

Beim Self-Consistency-Ansatz wird die KI angeregt, mehrere Antworten zu generieren und die häufigsten zu identifizieren. Mehrfaches Fragen hilft der KI, stabilere Ergebnisse zu erarbeiten. (mehr Informationen)

Löse folgende Textaufgabe auf drei verschiedene Arten und gib dann die häufigste Antwort als Endergebnis an:

Peter hat 12 Bonbons. Er gibt 3 an seine Schwester und 2 an seinen Bruder. Dann kauft er 5 neue Bonbons. Wie viele Bonbons hat Peter jetzt?

Man behandelt die KI quasi wie einen Menschen. Stell dir vor, du bist eine Lehrerin mit einem neuen Schüler. Mit Zero-Shot Prompting fragst du nach dem Prüfungsstoff. Beim Few-Shot Prompting führst du Beispiele an. Chain-of-Thought erfordert, dass der Schüler seine Antworten erläutert, während Self-Consistency ihn dieselbe Frage mehrfach beantworten lässt. Auto-CoT ermöglicht ihm schließlich, eigenständig an seinen Denkprozessen zu arbeiten. (mehr Informationen)

Was ist der System-Prompt und wofür kann ich ihn nutzen?

Der System-Prompt ist eine Eingabe, die einem LLM den Kontext und die Erwartungen für die Interaktion beschreibt. Er gibt an, was das Modell tun und wie es sich verhalten soll. Man kann ihn als „Meisteranweisung“ für das LLM betrachten.

Er wird in der Regel verwendet, wenn alle zukünftigen Anfragen nach diesen Anweisungen bearbeitet werden sollen, wie bei einem ChatBot, der zu einem bestimmten Thema antworten soll.

Für den System-Prompt überlegst du, welche Erwartungen du hast. Zum Beispiel könntest du angeben:

Du bist ein KI-Modell, das stets in frühem Neuhochdeutsch antwortet und sich wie ein Adelsmann verhält. Bei allen Antworten stelle höflich eine Nachfrage, ob es Rückfragen gibt.

Diese Anweisung ermöglicht dem Modell, relevantere und klarere Antworten zu liefern, und du kannst auch spezifische Stile oder Perspektiven anfordern.

Eine Beispielfrage an einen Chatbot mit diesem System-Prompt wäre:

Was hälts Du vom Nürnberger Wochenmarkt?

Der Chatbot könnte daraufhin antworten:

Wolgepflegte Grüß, edler Fragsteller. Der Nürnberger Wochenmarkt, ein Ort voller Füll und Trutz, biethet warlich ein köstlich Schawspiel an Wahren und Genüssen. Dort erblühet die Vielfalt der Erden, und die Kunst der Handwercker, sey es in Speysen oder Tranck, wirt gepreyßet. Der Austausch zwischen Händlern und Käuffern gleichet einem lebendigen Tantz, der die Gemüther erfrewet und den Gaumen kitzelt.

Würdet Ihr wünschen, mehr über die Gaben des Marckts zu hören oder gibt es andere Fragen, die Euch auff dem Hertzen ligen?

Übrigens funktionieren die “GPTs” bei ChatGPT nach dem gleichen Prinzip. Es sind letztendlich auch nur (komplexe) Prompts, die im Hintergrund das Model anweisen, was mit dem User-Input zu tun ist.

Dies ist der 1. Teil zu diesem Thema. In einem weiteren Blogbeitrag werde ich demnächst noch näher auf andere Facetten von GenAI eingehen.

Willst du noch mehr erfahren?

In einem 2. Teil zum Thema GenAI gehe ich näher auf Large Language Models ein und erkläre, wie sie funktionieren – von den Grundlagen über verschiedene GPT-Modelle bis hin zu innovativen Ansätzen wie Mixture-of-Experts und multimodalen Modellen.