Das Crawling bezeichnet in erster Linie den Vorgang, mit dem veränderte und neue Inhalte bzw. Seiten ermittelt werden, um diese später in den Suchindex von Google aufzunehmen. Suchmaschinen, vorzugsweise Google, besitzen eine Vielzahl von Crawlern (z.B. der Googlebot), die täglich damit beschäftigt sind, so viele Inhalte wie möglich zu untersuchen.

Der Googlebot und die Crawling-Geschwindigkeit

Dieser Googlebot besucht mehrmals am Tag die eigene Webseite, in der Regel optimiert dabei Google selbst die Häufigkeit des Besuchs in Abhängigkeit der Größe einer Webseite und natürlich der gewohnten Schreibfrequenz. Dies bedeutet: sofern eine Webseite in der Regel mehrmals am Tag neue Inhalte veröffentlicht, wird diese im Vergleich zu einer kleinen Webseite mit wenigen inhaltlichen Änderungen im Monat häufiger besucht.

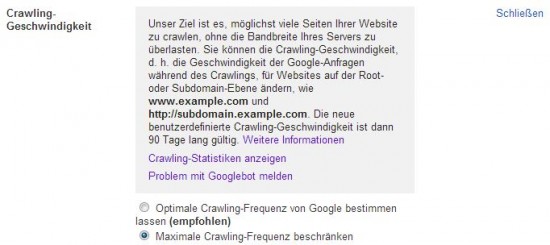

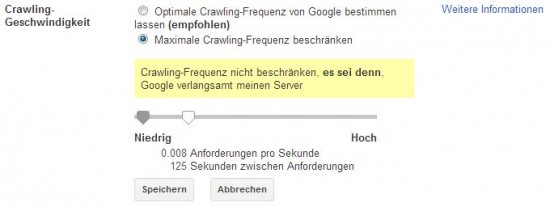

Wem dennoch die Besuchshäufigkeit des Googlesbots zu hoch erscheint, z.B. aufgrund des entstehenden Traffics / Datenvolumens, der kann diesen über die Google Webmaster Tools regulieren und somit eingrenzen.

Google selbst empfiehlt, die Crawling Geschwindigkeit nur in absoluten Ausnahmefällen, beispielsweise wenn dadurch die Geschwindigkeit/Performance des Servers deutlich verlangsamt wird, zu verändern.

Grundsätzlich sollte die Häufigkeit des Crawlings einer Webseite nicht verändert werden und der Rhythmus sollte seitens der Suchmaschinen bestimmt werden – schließlich möchten neue und bearbeitete Inhalte zeitnah in den Index aufgenommen werden und optimaler Weise direkt von potentiellen Besuchern und Kunden gefunden werden.

Probleme mit dem GoogleBot melden

Eine Anpassung der Crawling Geschwindigkeit ist in der Regel 90 Tage gültig und wird im Anschluss auf den Ausgangswert zurückgesetzt. Sollten tatsächlich durch den Googlebot signifikante Probleme auftauchen, so besteht auch die Möglichkeit die Probleme mit dem Googlebot zu melden (siehe Links zu weiteren Informationen in obiger Grafik).