Vom 15.03. bis 16.03. hat die inzwischen sechste SEO Campixx, initiiert von Marco Janck, am Berliner Müggelsee stattgefunden. Als einer der Sponsoren waren wir mit zwei Kollegen dabei. In ca. 120 Sessions gab es am Samstag und Sonntag Vorträge, Workshops und Gespräche zum Thema Suchmaschinenoptimierung bzw. den diversen Facetten des Online-Marketings.

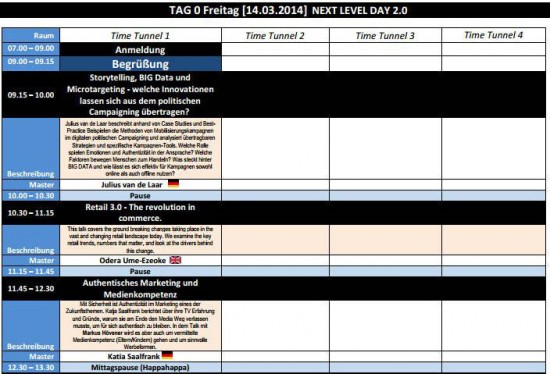

Wie bereits in den Jahren zuvor, startete die Veranstaltung mit einem zusätzlichen Tag: am 14.03. fand der sog. Next Level Day 2.0 statt.

Bei der großen Anzahl der Workshops ist es uns nicht leicht gefallen, die passenden Sessions herauszupicken. Es ist jedes Jahr wieder ein riesiger Spaß die passenden Workshops auszuwählen und auf der SEOCampixx darüber zu philosophieren, wie schwierig es ist sich zu entscheiden. Doch genau das gehört zur SEOCampixx dazu.

Tag 0: Der Next Level Day 2.0

Am Freitag startete der Next Level Day 2.0 pünktlich gegen 9 Uhr mit einer kurzen Begrüßung durch Marco Janck.

Julius van de Laar, Odera Ume-Ezeoke und Katia Saalfrank

Im Anschluss ergriff Julius van de Laar das Wort und berichtete uns in seinem spannenden Workshop darüber, wie er unter anderem den Obama-Wahlkampf in Ohio mithilfe von Big Data, Analysen und Kampagnen gestaltet hat. Zudem nannte Julias Methoden, wie potentielle Wähler ausgewählt und angesprochen wurden, damit diese Barack Obama ihre Stimme gaben. Diese Form des Wahlkampfs würde wahrscheinlich in Deutschland an der rechtlichen Situation wie auch dem Datenschutz scheitern. Nach einer Pause von 30 Minuten ging es weiter mit dem Workshop Retail 3.0 – The revolution in commerce von Odera Ume-Ezeoke.

Einer der authentischsten Vorträge war der Workshop mit Katia Saalfrank, auch bekannt als Supernanny aus dem Fernsehen. Der Workshop „Authentisches Marketing und Medienkompetenz“ wurde in Form eines Interviews geführt. Zum einen berichtete Katia Saalfrank über die Gründe des Ausstiegs aus dem TV-Programm und natürlich über die gewonnen Erfahrungen. Außerdem darüber, wie sich ihre Arbeit nachhaltig verändert hat und über den Vertrauens-Vorschuss, den sie im TV-Format „Supernanny“ hinzu gewinnen konnte.

Gesellschaft 2020 – Skizze einer Vision

von Jens Altmann

Als nächstes kam Jens Altmann zum Zuge, der sich in seinem Vortrag auf technische Veränderungen bis zum Jahre 2020 fokussierte. Dabei vergleicht er die gesellschaftlichen Veränderungen und Erfahrungen mit dem Lebenszyklus von technischen Produkten. Nach seiner Auffassung verändert sich nur nicht die Work-Life-Balance, sondern auch die Integration von technischen Produkten und Lösungen wird in Zukunft für eine andere Form der Wahrnehmung sorgen.

Marketing 2020: Strategien für die Granularisierung der Welt

von Joachim Graf

Den meisten dürfte Joachim vor allem durch das iBusiness Magazin (mit dem SEO/SEM TOP 100 Poster) wie auch einigen Vorträgen auf anderen Events bekannt sein. Er sprach in seinem Vortrag über die Veränderung der Märkte hin zu maßgeschneiderten Produkten basierend auf Kundenwünschen. Die Welt wird kleinteiliger.

Übrigens: Der Markt für Zeitschriften, Zeitungen und Magazine ist nicht tot und die Entwicklung zeigt, dass der Absatz langfristig weiter sinken wird, allerdings nicht so stark, dass solche Produkte im Jahre 2020 (wahrscheinlich auch nicht 2036 ) gänzlich von der Bildfläche verschwunden sein werden.

Vision Google Glass

von Patrick Zimmermann

Zu guter Letzt stellte uns Patrick Zimmermann die Datenbrille Google Glass vor. Natürlich ließ er es sich zu Beginn nicht nehmen, ein Foto von allen Workshop Teilnehmern zu machen und dieses auch mithilfe von Google Glass ins soziale Netzwerk Facebook zu stellen.

Nebst den Möglichkeiten und den Zukunftsaussichten der Datenbrille teilte uns Patrick auch seine Einschätzungen mit. Demnach funktioniert Google Glass nur stellenweise recht angenehm und auch die Anzahl an Anwendungen ist eher gering. Im Alltag sorgt die Datenbrille durchaus für negative Blicke der Passanten, weil diese sich aufgrund der ungewöhnlich aussehenden Brille (die Angst vor dem Unbekannten) beobachtet fühlen. Ferner reicht der Akku nicht sonderlich lange, so dass nach rund vier Stunden die Datenbrille Google Glass wieder an die Steckdose muss.

Tag 1: SEO Campixx 2014

Der erste Tag der SEO Campixx 2014 begann, vor allem für die Leute die am Next Level Day 2.0 nicht teilgenommen haben, mit einer kleinen Einführung und Ansprache durch Marco. Abschließend gab es noch eine kleine Roboter-Schau, nachdem der Raum im Nebel untergegangen war.

SEO & Affiliatemarketing im Adult-Bereich

von Christian Süllhöfer

Christian schaffte es in seinem ersten Workshop auf der SEO Campixx, den Saal komplett zu fesseln und in eine Branche einzuführen, die gerade in Deutschland eine Grauzone darstellt. Er zeigte anhand eines eigenen Beispiels, mit welch geringem Arbeitsaufwand interessante Erfolge zu verzeichnen sind und wie er das Know-How aus anderen Bereichen des Affiliate-Marketing in den Adult-Bereich übernehmen konnte.

Linkquellen finden und evaluieren

von Sergej Schäfer

Im Vortrag „Linkquellen finden und evaluieren“ beschrieb Sergej, wie er bei der Suche nach geeigneten Linkquellen vorgeht und diese mithilfe von Domainwerten, Strukturen und Inhalten bewertet.

Die Kunst der internen Verlinkung

von Sabrina Tietmeyer

Sabrina merkte man ihre Nervosität deutlich an, was auch dazu führte, dass kleinere Versprecher im Vortrag enthalten waren. Der Vortrag eignete sich sowohl für Anfänger wie auch Experten, weil selbst die Grundlagen eines internen Links erklärt wurden. Weiterhin zeigte Sabrina, welche Arten von internen Verlinkungen existieren und wie diese gewichtet werden.

In einem kurzen Gespräch am Abend stellte sich dann noch heraus, dass Sabrina für ihren Vortrag eine Vielzahl an Testszenarien erstellt hatte, worauf auch der Inhalt des Workshops basierte.

Dirty little Snippets

von Pascal Landau und Alexander Rosenthal

Im Workshop “Dirty little Snippets” gaben uns Pascal und Alexander einen Einblick in die Vielzahl an Snippets die für die Suchergebnisse, sprich unter anderem im Seitentitel und in der Meta-Beschreibung, verwendet werden können.

So spannend der Vortrag, die Tipps und Tricks hinsichtlich des Einsatzes von Rich Snippets zur Verbesserung der Sichtbarkeit in den Suchergebnissen waren, so enttäuschend ist, wie wenig die verschiedenen Browser am Ende zulassen.

Das heißt, vorausgesetzt Google erlaubt ein Snippet und zeigt dies in den Suchergebnissen an, bedeutet dies noch lange nicht, dass das gewünschte Snippet in jedem Browser und mobilen Endgerät korrekt ausgeliefert wird.

Die ultimative Keyword-Recherche

von Felix Meyer

Am Ende des Tages zeigte Felix, wie er eine ultimative Keyword-Recherche mithilfe der Datensätze verschiedener Toolanbieter und natürlich Excel durchführt.

Die gesammelten Daten wurden in Verbindung mit einer simplen Pivot-Tabelle aufbereitet, allerdings so, dass die komplette Struktur einer Website abgebildet werden konnte, wodurch Potentiale und Möglichkeiten mit einem geschulten Auge direkt erkannt werden konnten.

Pasta-Pate und Liveband

Am Abend gab es neben den gewohnten Grillwagen auch einen Pasta Paten, der eine echte Alternative darstellte. Natürlich gab es nebst der Verpflegung auch noch ein schönes Abendprogramm mit der Liveband „Coverpiraten“ aus Hamburg.

https://www.youtube.com/watch?v=j9vL4CBp_vo

Tag 2: SEO Campixx 2014

Nach dem bei einigen Teilnehmern der Samstag-Abend etwas länger ging, waren zumindest gegen zehn Uhr die Workshop-Räume nur teilweise gut gefüllt.

WordPress Extreme. Mit 100$ zum Powershop. Inkl. hidden Tricks

von Uwe Walcher und Dawid Przybyski

Ein Vortrag, der es in sich hatte, denn Uwe und Dawid zeigten uns, wie mithilfe des Blog-Systems ein WordPress Shop erstellt werden kann, der binnen weniger Minuten mit mehreren tausend Produkten bestückt ist und am Ende des Tages bereits den einen oder anderen Euro an Provision erwirtschaften kann. Dies setzt natürlich voraus, dass der Anwender in seiner Tätigkeit durchaus kreativ ist. Spannend war vor allem, dass sowohl Uwe als auch Dawid nicht nur sagten „ja, es geht irgendwie so“ sondern auch zeigten, wie hoch ihre Einnahmen sind und wodurch sie zustande kommen.

“Speed up your page!”

von Dennis Elsner

Dennis zeigte uns in seinem Vortrag, worauf es zu achten gilt, wenn die Geschwindigkeit einer Website verbessert werden soll und wie Google einzelne Elemente bewertet. Im Kern des Vortrags standen verschiedene Coachingmöglichkeiten sowie Apache-Module wie auch Googles Pagespeed.

„Einfach Geld verdienen mit Affiliate Projekten: Sind die Zeiten vorbei?“

von Darius Erdt und Christian Hübsch

Vom Tellerwäscher zum Millionär binnen weniger Stunden, zumindest in der Theorie klingt das relativ nett. Darius und Christian gingen darauf ein, wie sich der Markt, bedingt auch durch Google Updates, in den letzten Jahren verschärft hat und mittlerweile deutlich mehr Arbeit investiert wurde. Der als Interview geführte Workshop zeigte, welche Erfahrungen in den letzten Jahren gemacht wurden und worauf geachtet werden muss, wenn eine Familie vom Affiliate-Marketing ernährt werden muss.

Fazit der diesjährigen SEO Campixx 2014

Die SEO Campixx 2014 war, wie eigentlich nicht anders zu erwarten, ein voller Erfolg. Es gab spannende Vorträge, die wieder mal den Horizont erweitern konnten und diverse Insights, die für neue Ideen sorgten. Nebst den diversen Workshops gab es auch spannende Gespräche wie z.B. mit Soeren Eisenschmidt (eisy.eu) oder René Dhemant aus dem Hause unseres Tools Partners Sistrix.

Ein besonderes Highlight war in diesem Jahr auch der Pasta-Pate als Alternative zum umstrittenen Grillwagen. Für das nächste Jahr hat sich das Team von Sumago etwas Neues einfallen lassen und präsentiert vorab die SEO Campixx Week mit verschiedenen Themenbereichen.

Abschließend hier noch die Recaps der Branchen-Kollegen und -Kolleginnen:

- Ines auf pheminific.de

- Felix auf felixbeilharz.de

- Julian auf Seokratie.de

- Sebastian auf sblum.de

Eine Liste aller Recaps gibt es beim Sitefuchs.