Crowd Sourcing meint, dass massenweise Leute über das Netz an etwas zusammen arbeiten können. Wikipedia, Google Docs, Firmen-Intranets… You name it. Und ein Modell ist abstrakter als das andere.

Haben Sie auch früher mit LEGO die abgefahrensten Dinge gebaut?

Häuser, Schiffe, Autos, Raumstationen und Ritterburgen… Was haben wir nicht alles aus den kleinen, dänischen Klötzchen für Welten erschaffen. Zahllose Nachmittage, an denen unsere Knie tiefe Beulen im Kinderzimmerteppich hinterlassen haben. Und dann haben wir unsere Werke stolz ins Wohnzimmer getragen, um sie ein paar Tage später fallen zu lassen und nach dem großen SCHEPPER! die Steinchen nach und nach aus den hintersten Zimmerecken zu fischen und zu einem neuen Kunstwerk zusammen zu setzen.

1,7 mm hohe Noppen, die Welten zusammen halten und uns in Sekunden die Vergänglichkeit unserer Arbeit vor Augen führten.

Heute sieht das plötzlich ganz anders aus: Wir können uns nicht nur wie der Bielefelder Schriftsteller Mischa Sarim-Verrolet beim Bauen unseres LEGO Bullis zuschauen lassen und unsere Bauwerke nicht nur im Web für die Ewigkeit festhalten, sondern uns Anregungen in LEGO Blogs holen, wo virtuose Klötzchen-Architekten ganze Filmsets nachbauen oder sogar filmreife Modelle entwerfen.

Crowd Sourcing heisst gemeinsam arbeiten

So wie wir früher gemeinsam an einem LEGO-Projekt gearbeitet haben, können wir heute mit Crowd-Sourcing und Cloud-Anwendungen auch im echten Leben echte Projekte umsetzen und Meilensteinchen an Meilensteinchen reihen. Eigentlich logisch, diese beiden Dinge zusammen zu führen, oder?

Neben privat erstellten LEGO-Bauplänen, die von anderen runtergeladen, kommentiert, verbessert und erweitert werden können, hat LEGO als Unternehmen mittlerweile eine clevere Crowd-Sourcing Plattform aufgebaut.

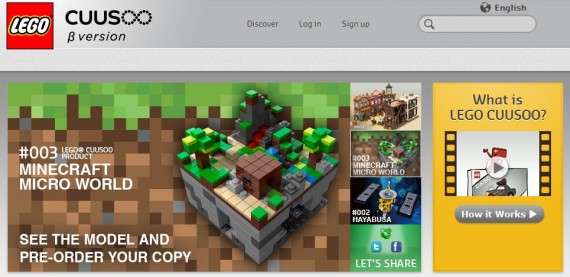

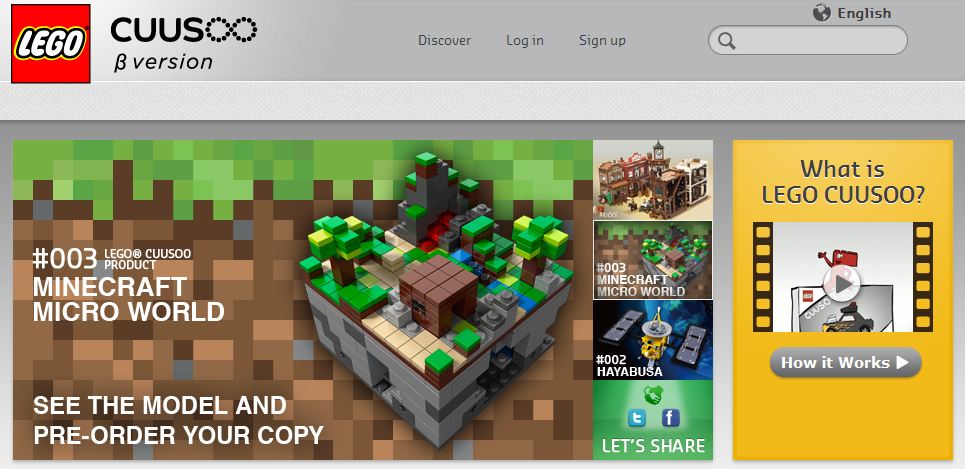

Auf dem Portal LEGO.cuusoo.com können Fans ihre fertiggestellten (mit Teileliste und Bauplan dokumentierten) LEGO-Fan-Projekte vor- und zur Wahl stellen.

Projekte, die durch die Community mindestens 10.000 Stimmen erhalten, werden von LEGO in Betracht gezogen, als tatsächliches Produkt in den Handel zu kommen.

Warum vertraut LEGO auf diese Schwarmintelligenz der Kunden?

Seit 90 Jahren ist LEGO einer der erfolgreichsten Spielzeughersteller der Welt – 2012 ist tatsächlich Jubiläumsjahr. Warum sollte sich das Unternehmen von Kunden in die Produktentwicklung reinreden lassen? Hier die 5 offensichtlichsten Gründe:

- Innovative Produkte entstehen

- Grundabsatz unter den Projekt-Supportern ist relativ sicher

- Hohe Akzeptanz durch den „Mitmach-Faktor“

- Virale Verbreitung auch der nicht realisierten Projekte in Social Networks

- Awareness für die Marke LEGO

Minecraft wird durch LEGO Cuusoo aus der Virtualität in die Anfassbarität gebracht

Ein Beispiel für perfektes Crossmarketing: Minecraft ist wohl DAS Computer-Spiel-Phänomen der letzten Jahre. In dem kostenlosen Online-Spiel kann der Spieler eigene Welten zusammenbauen. Aus Klötzchen.

Was liegt da näher als Minecraft mit Hilfe von LEGO in die echte Welt zu überführen? Doch weder LEGO noch der Spiele-Entwickler Markus Persson kamen auf die Idee, sondern die Cuusoo Community. Vier auf dem Globus verteilte Fans entwickelten zusammen mit einem LEGO-Designer den ersten Minecraft-LEGO-Baukasten, der seit Juni auch in Deutschland für 34,95 im Regal steht.

Erste Blogs berichten bereits begeistert über das fertige Produkt:

Video hier entdeckt

Hinterlassen Sie uns doch einen Kommentar, wie Massenzusammenarbeit mit Kunden für Ihre Produkte aussehen könnte!

Durch einen Hinweis auf dieses LEGO Autoprojekt, das ich gleich in meinem eigenen Blog verwendet habe, bin ich auf LEGO.Cuusoo aufmerksam geworden

Ab sofort sind die Share-Plugins auf unseren Seiten von Allyve und somit bieten wir eine rechtssichere Integration des Like-Buttons von Facebook. Deutsche Datenschutzbehörden haben zuletzt immer wieder eine

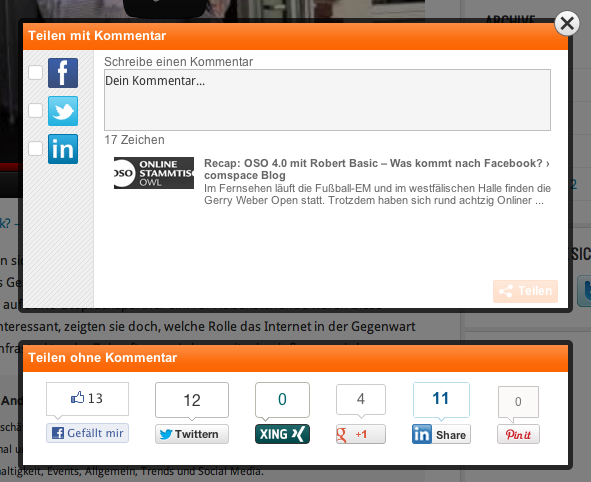

Ab sofort sind die Share-Plugins auf unseren Seiten von Allyve und somit bieten wir eine rechtssichere Integration des Like-Buttons von Facebook. Deutsche Datenschutzbehörden haben zuletzt immer wieder eine  Webseiten-Besucher können interessante Inhalte schnell und einfach in alle relevanten sozialen Netzwerke teilen. Der Content kann sich so schnell viral verbreiten, was zu steigenden Nutzerzahlen auf dem eigenen Angebot führt. Da aber niemand eine Vielzahl unterschiedlicher Icons auf der eigenen Seite unterbringen möchte, sind verschiedene Unternehmen auf die Idee gekommen diese Buttons hinter einem „Teilen“-Button zusammenzufassen. Als Mehrwert steht dem Nutzer oft eine Multisharing-Option zur Verfügung, die so das mehrfache Anklicken verschiedener Buttons auf wenige Klicks reduziert.

Webseiten-Besucher können interessante Inhalte schnell und einfach in alle relevanten sozialen Netzwerke teilen. Der Content kann sich so schnell viral verbreiten, was zu steigenden Nutzerzahlen auf dem eigenen Angebot führt. Da aber niemand eine Vielzahl unterschiedlicher Icons auf der eigenen Seite unterbringen möchte, sind verschiedene Unternehmen auf die Idee gekommen diese Buttons hinter einem „Teilen“-Button zusammenzufassen. Als Mehrwert steht dem Nutzer oft eine Multisharing-Option zur Verfügung, die so das mehrfache Anklicken verschiedener Buttons auf wenige Klicks reduziert.