Recht häufig stellt sich dem Webmaster und Laien die Frage, welcher Domainname und vor allem welche Domain-Endung ist eigentlich die Richtige?

Ein Domainname sollte grundsätzlich mit der Thematik einer Webseite in Zusammenhang stehen. Wenn nach intensiver Suche und diversen Domainabfragen der passende Name für das Vorhaben gefunden wurde, stellen sich in der Regel weitere Fragen. Vor allem bei Begrifflichkeiten, die sowohl getrennt als auch zusammen geschrieben werden können, taucht häufig vor der Registrierung einer Domain die Frage auf: „Welche der beiden Domainnamen nehme ich jetzt?“.

Die Antwort ist immer: Beide.

Natürlich kosten zwei Domains mehr als eine, allerdings ist es grundsätzlich immer sinnvoll, die relevantesten Domains für sein Vorhaben zu registrieren und damit sein eigen zu nennen. Denn mal angenommen, man schafft sich eine Brand oder eine sehr gut besuchte Seite, so bietet man potentiellen Konkurrenten nicht die Chance, aus dem eigenen Namen einen Nutzen zu ziehen. Das gilt auch für getrennt und zusammen geschriebene Domains (www.do-main.de und www.domain.de).

Was gilt es weiterhin zu beachten?

- Kunstwörter vermeiden

Das Erschaffen einer Brand ist sicherlich toll und der Wunschtraum eines jeden Websitenbetreibers. Aber das Erschaffen einer Brand durch ein Kunstwort ist in der Regel sehr zeit- und kostenintensiv – Namen die keiner kennt, werden auch bei Suchmaschinen nur sehr selten gesucht. - Einzahl oder Mehrzahl?

Auch hier gilt die Antwort „Beide“. Wer sich eine Domain mit dem Namen im Singular registriert, läuft Gefahr, dass er irgendwann Besucher an einen Konkurrenten verliert, der sich den Domainnamen im Plural registriert hat. Gerade Domainhändler sind darauf fixiert, sich solche Domains zu sichern, um diese im Anschluss selbst zu vermarkten oder diese für einen hohen Preis an Sie zu veräußern. - Leicht zu merken und so kurz wie möglich

Bei der Wahl des Namens sollte darauf geachtet werden, dass dieser so kurz wie möglich ist, damit sich Kunden und Besucher diesen sehr leicht merken können und im besten Fall, aufgrund der Einfachheit, verbreiten. - Markenrecht

Ja, auch Domainnamen unterliegen eventuell einem Markenrecht. Dem entsprechend vorab immer darauf achten, ob der Domainname geschützt wurde. Deshalb sollte man sich immer die 5 Min Zeit nehmen und vorab auf der Seite des deutschen Patent- und Markenamts den Domainnamen abfragen.

Welche Endung sollte genommen werden?

Natürlich könnten jetzt pauschal alle Endungen oder lediglich eine Endung registriert werden, allerdings sinnvoll sind Endungen wie .de für Deutschland (für Österreich .at, für die Schweiz .ch), .com, .net, .org, .info, .eu – nach wie vor gelten diese Domain-Endungen als deutlich vertrauenswürdiger im Vergleich zu unsympathischen Endungen wie zum Beispiel .biz.

In der Regel kriegt man im Anschluss die Antwort: Aber ich will doch nur eine Webseite erstellen und nicht vier bis fünf. Das ist auch richtig. Daher sucht man sich eine Hauptdomain aus und leitet die anderen Domains auf diese Hauptdomain weiter. Damit vermeidet man, dass andere Websitebetreiber sich die guten Domain-Endungen sichern.

Generische Domains und deren Zielausrichtung?

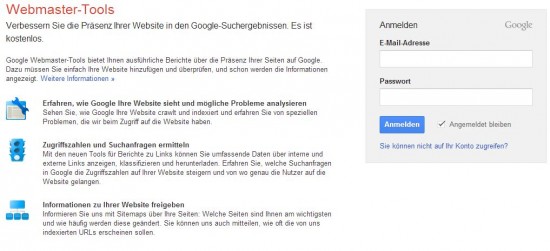

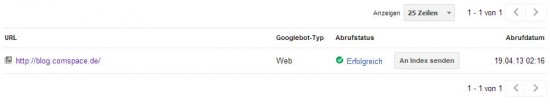

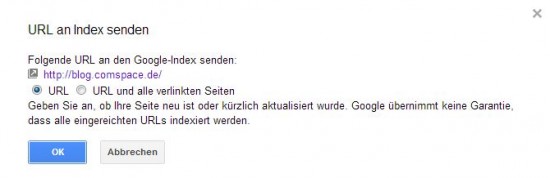

Ein Problem der generischen Domains ist dass diese in erster Linie nicht einem Land zuzuordnen sind. Bei Domains mit der Endung .de ist davon auszugehen, dass diese sich auf den deutschen Sprachraum beziehen, Ausnahmen bestätigen die Regel. Bei Domain-Endungen wie zum Beispiel .org weiß man in der Regel nicht, in welchem Sprachraum sich die Website befindet. Daher ist es empfehlenswert, die Domain in die Google Webmaster Tools einzutragen, darüber die geografische Zielausrichtung anzusteuern und der Domain einschließlich Endung einen Sprachraum zuzuweisen.

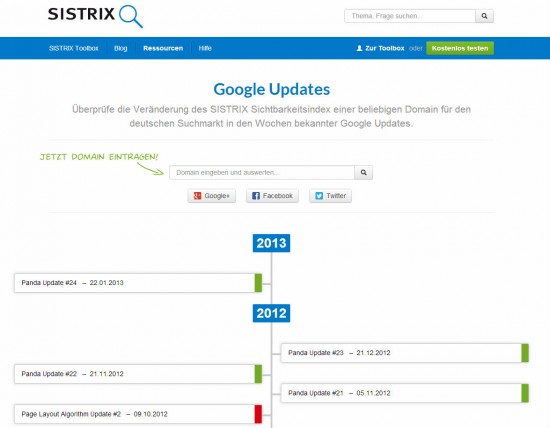

Mithilfe des Panda Updates wird seit dem ersten Update im August 2011 die Qualität des Inhalts bewertet und diese Bewertung fließt in das Ranking einer Website ein. Bevor das Update in Deutschland eingespielt wurde, war es im Bereich des Online-Marketings schon länger Gesprächsthema Nr. 1 – zu Beginn lief das Update noch unter dem Namen Farmer Update.

Mithilfe des Panda Updates wird seit dem ersten Update im August 2011 die Qualität des Inhalts bewertet und diese Bewertung fließt in das Ranking einer Website ein. Bevor das Update in Deutschland eingespielt wurde, war es im Bereich des Online-Marketings schon länger Gesprächsthema Nr. 1 – zu Beginn lief das Update noch unter dem Namen Farmer Update.