Nach dem bereits im August 2011 das Google Panda Update die Suchergebnisse ein wenig durcheinander gewirbelt hat, folgte im April 2012 das Pinguin Update / Penguin Update.

Ähnlich wie bei dem Panda Update waren auch Websites und Webportale betroffen, die nicht gegen die Google Webmasterrichtlinien verstießen – wodurch vermutlich wiederum einige Existenzen ins Wanken gerieten. Kollateralschäden sind auch bei einem Google Update nicht auszuschließen, dem entsprechend wird es, wie bereits im Artikel zum Panda Update beschrieben, langfristig immer wichtiger, sich auf mehr als nur eine Traffic-Quelle zu konzentrieren.

Auswirkungen des Penguin Updates

In erster Linie sollte sich das Google Penguin Update an Websites richten, die als überoptimiert gelten.

Zu Beginn war die Frage, worauf sich das überoptimiert bezieht:

Sind damit On-Page Maßnahmen gemeint, wurden zu oft Überschriften deklariert oder ist der Quellcode zu sauber/aufgeräumt? Oder bezieht sich dies auf externe Faktoren wie das Linkbuilding?

Ersteres kann eigentlich nur bedingt eine Ursache sein, schließlich schreibt Google selbst in den Webmaster Richtlinien, dass eine Website zwingend ausreichend strukturiert und technisch einwandfrei arbeiten muss. Bis dato werden durch diese Richtlinien keine Begrenzungen in Bezug auf den Einsatz bestimmter OnPage Elemente gesetzt, so dass hier jedem Websitebetreiber freigestellt wird, wie er seine Website strukturieren und aufbauen möchte. Ausgenommen sind natürlich Techniken wie das Cloaking, die explizit verboten sind. Zudem dürfte der Bereich der On-Page Optimierung mithilfe des Google Panda Updates bereits „abgedeckt“ sein.

Relativ schnell berichteten die Online Marketing Experten davon, dass die externen Faktoren (Offpage), also das Linkbuilding die Problemquelle darstellen. Links, auch Backlinks, fließen seit der Erschaffung des Google PageRank Algorithmus in die Bewertung von Websites mit ein.

Betroffene Ranking-Faktoren

In erster Linie bezieht sich das Update auf gekaufte und nicht organisch aufgebaute Links. Der Kauf wie auch der Handel mit Backlinks ist bereits seit einigen Jahren durch die Google Webmasterrichtlinien verboten – dennoch ist das Linkbuilding ein relevanter Faktor, gerade in umkämpften Nischen.

Frank Doerr berichtet unter dem Pseudonym Loewenherz auf seo-scene.de darüber,

dass primär Webseiten betroffen sind, die bei durchschnittlich mehr als 60 % der eingehenden Links ein Money-Keyword im Archnortext verwenden. In der Regel waren Websites mit weniger als 50 % Money Keywords bei eingehenden Backlinks nicht betroffen. Das lässt darauf schließen, dass das Pinguin Update ein Ankertext Penalty ist.

Bevor jetzt aber die Meinung entsteht, gute Websites dürften bis max. 59 % Money Keywords enthalten, sollte beachtet werden, dass auch Websites mit weniger als 50 % betroffen sind und es hier keine Gesetzmäßigkeit gibt, die dem Websitebetreiber einen Freibrief für 49 % oder 59 % Keyword Backlinks ausstellt. Der Suchmaschinenbetreiber Google wird in Zukunft immer genauer darauf achten, wie sowie mit welchen SEO relevanten Keywords Backlinks aufgebaut wurden und aus welchen Quellen eben diese entspringen.

Eine weitere Auswirkung des Pinguin Updates ist, dass ein gescheiter Linkmix aus themenrelevanten und nicht themenrelevanten Seiten existieren sollte. Dieser Punkt wird auch seit einigen Jahren im Zuge des organischen Linkaufbaus vermittelt.

Exkurs: Was ist ein organischer Link?

Organisch beschreibt in erster Linie, das ein Link natürlich sein sollte. Natürliche Links sind in der Regel Links die z.B. in Foren von Usern gesetzt werden, die anderen Personen mithilfe eines relevanten Links einen Tipp oder gar eine Problemlösung offerieren wollen.

In den seltensten Fällen werden natürliche Links mit einem SEO Keyword versehen, sondern durch Begriffe wie „hier“, „Link“, „schau mal hier“ oder der URL selbst gekennzeichnet.

Was kann getan werden, wenn eine Website betroffen ist?

Grundsätzlich wird es wohl einen Grund haben, warum eine Website von einem Google Penalty betroffen ist und diejenige Personen wird in den meisten Fällen auch wissen, warum die Website durch das Google Pinguin Update in seinen Rankings abgewertet wurde. Dennoch gibt es auch die Möglichkeiten, sein Ranking langfristig wieder zu verbessern.

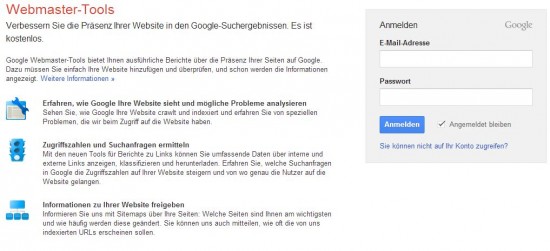

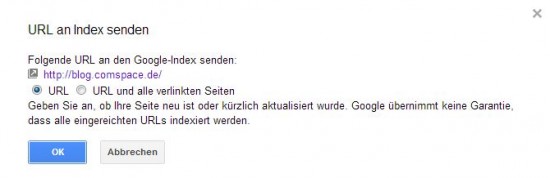

Anmerkung: Ein Reinclusion-Antrag, also einen Antrag zur Wiederaufnahme in den Index, der in den Google WebmasterTools zur Verfügung gestellt wird, wird wahrscheinlich keinen Nutzen haben. Da dies Update eine Erweiterung des Google Algorithmus ist und kein (manueller) Filter.

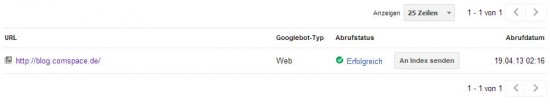

Eine Möglichkeit ist es, die gekauften und selbst aufgebauten Backlinks abzubauen, dazu sollten die externen Links durch eine Backlink Analyse vorab durchleuchtet werden.

Der Abbau von Backlinks ist ein strittiges Thema im Online Marketing bzw. in der SEO-Welt. Die einen sind der Meinung, dass somit gegenüber Google gezeigt wird, dass Links, aus ggf. noch nicht bekannten Quellen aufgebaut, wurden – die anderen sehen es als logische Konsequenz um langfristig wieder Erfolge in den Rankings feiern zu dürfen.

Seit Mitte Oktober 2012 hat Google ein Tool in den Google WebmasterTools vorgestellt, womit die Linkkraft von Backlinks entwertet werden kann. Wer jetzt denkt – „super muss ich mir keine Arbeit mehr machen und entwerte die Links über das Tool“ dem sei gesagt, dass Google laut eigener Aussage dies nur zur Verfügung stellt, damit auch die Links entwertet werden können, die selbst nicht abgebaut werden können.

Auch dieses Tool gilt als heikles Thema – es gibt Marketing-Experten die hier von Verrat sprechen, da durch das Abbauen, Entwerten von Links Google Linkquellen und damit auch organisierte Linknetzwerke offenbart werden und kurz- bis langfristig nicht mehr nutzbar sind.

Blognetzwerke, Linknetzwerke und allgemein „kostenlose und günstige Linkquellen Netzwerke“ besitzen schon seit geraumer Zeit nicht mehr die gewünschte Backlink-Qualität. Quantität ist eben nicht gleich Qualität, auch wenn das immer noch nicht jeder wahrhaben möchte.

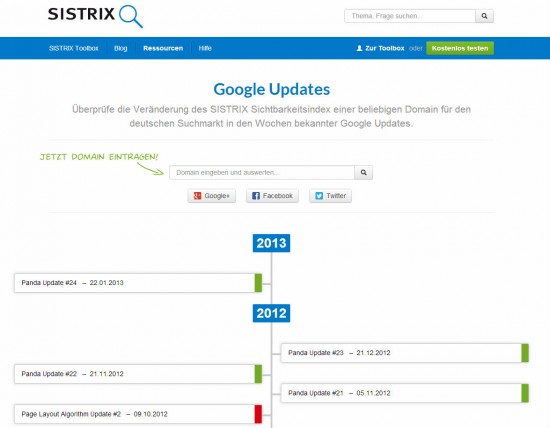

Bevor sich jetzt jemand an die Arbeit macht und fleißig Backlinks entwertet, die er ggf. gar nicht selbst gesetzt hat, sollte vorab überprüft werden, ob die Website wirklich durch das Pinguin Update betroffen ist – schließlich gibt es mit dem Panda-, Venice-, Freshness- und EMD-Update vier weitere Updates, welche die Google Rankings beeinflussen können.

Was versucht Google mit dem Pinguin Update?

Google versucht Ankertexte (Keywords / Schlagworte die Links kennzeichnen) zu entwerten. D.h. Google will weiterhin das Linkbuilding, den Linkhandel in allen Formen und Farben, entgegen zu wirken.

Was sagt Google offiziell zum Pinguin-Update?

(Quelle: www.website-boosting.de | Prof. Dr. Mario Fischer )

„to reduce webspam and promote high quality content“

Laut dem Suchmaschinenbetreiber Google selbst, waren von der ersten Variante des Pinguin Updates ca. 3 % aller Suchabfragen betroffen.

Literatur

Einen sehr interessanten Artikel zum Penguin-Update hat Hanns Kronenberg aus dem Hause der Sistrix Toolbox heute veröffentlicht. Dabei wurden 50 Domains/Websites überprüft, die durch das Penguin Update betroffen waren bzw. sind und wie sich eben diese Seiten in den vergangenen Monaten entwickelt haben.

Mithilfe des Panda Updates wird seit dem ersten Update im August 2011 die Qualität des Inhalts bewertet und diese Bewertung fließt in das Ranking einer Website ein. Bevor das Update in Deutschland eingespielt wurde, war es im Bereich des Online-Marketings schon länger Gesprächsthema Nr. 1 – zu Beginn lief das Update noch unter dem Namen Farmer Update.

Mithilfe des Panda Updates wird seit dem ersten Update im August 2011 die Qualität des Inhalts bewertet und diese Bewertung fließt in das Ranking einer Website ein. Bevor das Update in Deutschland eingespielt wurde, war es im Bereich des Online-Marketings schon länger Gesprächsthema Nr. 1 – zu Beginn lief das Update noch unter dem Namen Farmer Update.