Als Sitecore Certified Solution Partner nehmen wir jede Gelegenheit wahr, unser Sitecore-Team weiter zu bilden und uns mit den aktuellen Entwicklungen des Content Management Systems auseinanderzusetzen.

Eine solche Gelegenheit bietet sich uns wie allen anderen Sitecore-Experten vom 4. – 6. September 2012 anlässlich des Sitecore Symposiums Europe in Amsterdam. Im dritten Jahr in Folge lädt der führende Hersteller im Bereich .NET Content Management Systeme alle interessierten Sitecore Partner, Entwickler und Kunden Europas zu einem Austausch von Informationen, Knowhow und Erfahrungen ein.

Zum Auftakt erwarten die Teilnehmer zwei spannende Keynotes: In der ersten stellt Sitecore-CEO Michael Seifert seine Vision von der Zukunft des Web vor und wir sind gespannt, was sich seit seinem Vortrag anlässlich des letzten Sitecore-Symposiums in Nordamerika vor 8 Monaten getan hat.

Die zweite Keynote hält Gastredner Brian Solis, Social Media-Vordenker, prominenter Blogger und weltweit gefragter Referent. Sein Ansatz einer ganzheitlichen digitalen Strategie, die, statt sich in isolierten Social Media-Maßnahmen zu erschöpfen, das gesamte Unternehmen mit seinen Entscheidungs- und CRM- Strukturen erfassen sollte, hat er kürzlich auf einem Social Media-Gipfel in Amsterdam dargelegt.

http://www.youtube.com/watch?v=21B60siC_l8&feature=player_embedded

Im Anschluss daran bietet das umfangreiche zweitägige Programm eine Vielzahl an Sessions: In drei parallelen Vortragsreihen (Product Track, Business Track und Developer Track) bekommen die Teilnehmer jede Menge Produkt- und Anwendungsinformationen, best practice cases und Trainings rund um bestehende und kürzlich herausgebrachte Sitecore-Produkte wie MVC, Mobile Framework und Social Connect präsentiert.

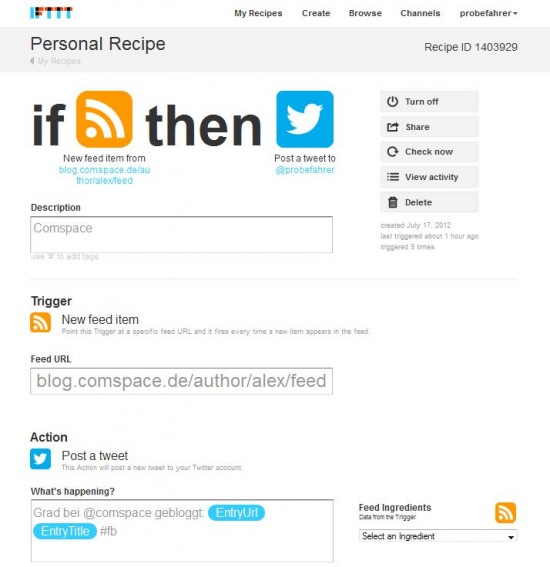

Social Media-aktive Teilnehmer können sich an einem Social Contest beteiligen und Überraschungspreise gewinnen. Ausgeschreiben sind zwei Wettbewerbe: den „#SitecoreSym Most Engaged“ gewinnt derjenige, der sich während des Symposiums am meisten in den Social Media Kanälen zum Thema Sitecore engagiert. Im „#SitecoreSym Post-Event“ wird der Teilnehmer ausgezeichnet, der sich von Beginn des Symposiums an durchgehend bis zum 30. September besonders Social Media-aktiv zeigt.

Die beteiligten Kollegen aus unserem Sitecore Entwicklerteam und dem Account Management freuen sich auf zwei intensive Tage des Lernens, Diskutierens und Netzwerkens mit anderen Partner und Entwicklern. Schließlich hat man nicht alle Tage Gelegenheit, seine Fragen und Anregungen in direktem Austausch mit den Führungskräften von Sitecore zu diskutieren. Wir sind gespannt auf ihre Eindrücke und Berichte.