„Mobile Webseite? Brauchen wir nicht. Wir haben ja keine Kunden, die unsere Leitungen von unterwegs nutzen. Unsere Webseite muss keine Touristen ansprechen, die auf der Suche nach einem Restaurant sind und auch keine hippen Jugendlichen, die auf einer Party „einchecken“ wollen.“

Wirklich nicht? 5 Gründe für eine mobile Webseite:

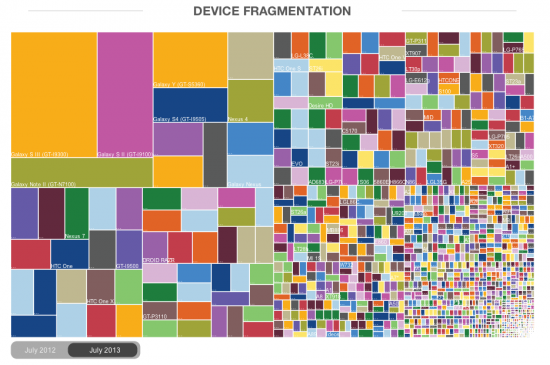

Letztens griffen wir hier die problematische Vielfalt mobiler Endgeräte auf. Im Umfeld dieses Themas möchten wir Ihnen auch einige Gründe nennen, warum eine mobile Webseite Sinn macht.

(cc) Gregor Fischer

1. Google legt immer mehr Wert auf mobile Webseite

In einem Beitrag in Googles Webmaster Central Blog vom 11. Juni listet Google die Faktoren auf, mit denen mobile Webseiten in das Suchergebnis-Ranking einfließen und welche Fehler zu vermeiden seien, um das Rankingergebnis nicht negativ zu beeinflussen und welche Maßnahmen sich positiv auswirken:

- Weiterleitungen sollten immer zu relevanten Seiten führen

- nichtdarstellbares Flash auf mobilen Webseiten

- Keine Umleitungen nur für bestimmte mobile Geräte

(Google Bot identifiziert sich aktuell interessanterweise als iPhone – sollte auch als solcher behandelt werden) - Videos, die in mobilen Endgeräten u.U. nicht laufen sind kritisch

- Eine mobile Ausrichtung einer Seite kann sich sogar positiv auf das Suchergebnis auswirken

Dies ist nur die Spitze des Eisbergs. Wir gehen stark davon aus, dass die mobile Verfügbarkeit und Darstellbarkeit von Webseiten zukünftig immer relevanter für hohe Positionen in Suchergebnissen werden wird.

2. Mobile Suchvorgänge finden nur zu kleinem Teil von unterwegs statt, oder?

Was schätzen Sie, wie viele mobile Suchen überhaupt von unterwegs durchgeführt werden? Also auf Reisen, im Auto, während des Flanierens beim einkaufen? Ziemlich genau ein Viertel.

Gar nicht mal so viel, oder? Mich hat diese Zahl aus einer aktuellen Nielsen Studie jedenfalls sehr überrascht. Genau genommen werden 77% aller Suchen auf mobilen Endgeräten von zu Hause oder dem Arbeitsplatz aus durchgeführt. Wenn ich mich da mal selber als Zielgruppe beobachte, dann passt das sehr gut. Bevor ich das Notebook aufklappe um nach einem Produkt zu suchen, hole ich viel eher das Smartphone aus der Tasche. Der Zweit-Bildschirm, der abends auf der Couch genutzt wird, ist das Tablet.

3. Sind mobile Suchen denn wirklich schon relevant?

Relevanz zu definieren ist immer so eine Sache 😉 In diesem Fall möchte ich eine weitere Zahl aus der Nielsen Studie in den Ring werfen: 73% mobiler Suchanfragen lösen zusätzliche Aktionen und Konversionen aus und 28% führen direkt zu Konversionen:

- 36% führen zu weiterer Recherche des Kunden

- 25% führen auf eine Händlerseite

- 18% teilen Informationen weiter

- 17% führen direkt zum Kauf

- 17% beuschen ein stationäres Geschäft

- 7% resultieren in Anrufen

4. Mehrgeräte-Nutzung verbreitet sich immer mehr

Diese Infografik von Google zeigt sehr eindruckslvoll, wie stark typische Nutzungsszenarien auf mehreren Bildschirmen unterschiedlicher Größe durchgeführt werden:

Es geht also in den meisten Fällen gar nicht um die Optimierung einer Seite für einen bestimmten Kanal, sondern vielmehr um eine ganzheitliche Lösung, die alle Darstellungsoptionen wie Smartphone, Tablet, Ultrabook, Arbeits-PC und sogar Fernseher mit einbezieht.

5. Zukünftige Entwicklung mobiler Suchanfragen

Die Kollegen von gjuce haben hier einmal eine mögliche Entwicklung der Suchanfragen mobil vs. Desktop abgeleitet und in ein Kurvendiagramm gegossen. Ich würde hier nicht auf die exakte Nachkommastelle achten, halte den Trend aber für sehr realistisch:

Fazit: Prüfen Sie, welche Zielgruppe und Nutzungszenarien in Frage kommen

Dies waren 5 Gründe, die für den positiven Nutzen und die zunehmende Relevanz einer mobilen Webseite sprechen, auch wenn man nicht gerade Deutsche Bahn oder Lufthansa heißt.

Wenn Sie herausfinden möchten, ob sich eine mobil darstellbare Webseite für Ihr Unternehmen jetzt schon lohnen kann, sollten Sie sich die folgenden Fragen stellen:

- Welche Handlung/Konversion soll beim Besuch Ihrer Webseite ausgelöst werden?

- Wie sehen Ihre Zielgruppen aus?

- In welchen Situationen nutzen diese Zielgruppen Ihre Webseite?

- Welche Inhalte sollten mobil angeboten werden und welche nicht um die angestrebten Konversionen zu erreichen?

- Sollte die bestehende Webseite „mobilisiert“ werden oder ein eigener mobiler Kanal eingerichtet werden?

Die

Die