Google lässt Universal Analytics sterben. Es ist ein Abschied auf Raten. Am 1.7.2023 zieht man bei Google den Stecker und wer bis dahin kein Google Analytics 4 (GA4) implementiert hat, guckt in die leere Daten-Röhre. Abgesehen von Bequemlichkeit gibt es keinen Grund, nicht so schnell wie möglich umzusteigen – aber viele Gründe, es sofort zu tun.

„Google Analytics 4: Wie der Wechsel klappt“ weiterlesenDie Google Updates 2021: Page Experience & Mobile Only

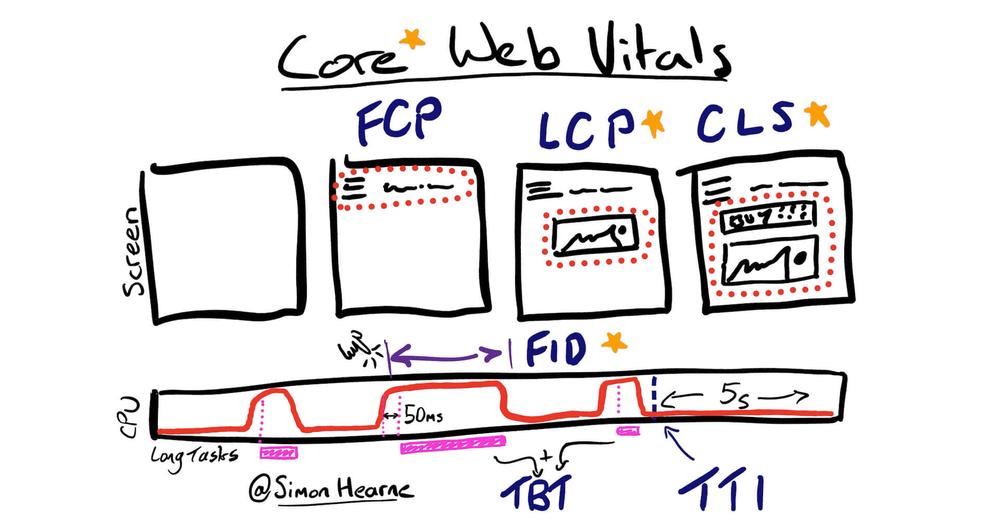

Mit der Ankündigung von zwei Neuerungen in 2021 treibt Google die technische Entwicklung von Websites weiter voran. Ab März wird das Mobile First Indexing für alle Webseiten zum Standard und ab Mai Mitte Juni erhebt Google mit dem Page Experience Update die Nutzererfahrung zum Rankingfaktor.

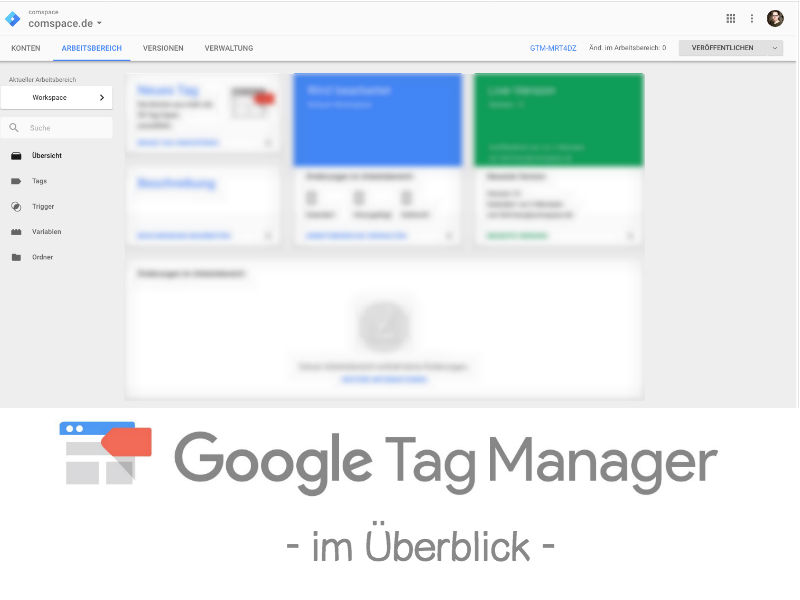

Der Google Tag Manager im Überblick

Was ist der Google Tag Manager?

Im Oktober 2012 hat Google den Tag Manager veröffentlicht, der das Tracking auf Webseiten vereinfachen und unterstützen soll – daher benötigt der Anwender für die Basisfunktionen keine speziellen Programmierkenntnisse.

Der Google Tag Manager ermöglicht die Messung und Identifizierung des Nutzerverhalten auf der Webseite und verbindet über Tracking-Codes gängige Web-Analyse und Marketing-Tools. Durch den Google Tag Manager kann so das Nutzerverhalten im Hintergrund verfolgt werden. Diese gewonnenen Daten können genutzt werden um Ihre Webseite zu verbessern und zu optimieren.

Wie funktioniert der Google Tag Manager?

Wurden bis dato auf jeder Webseite und Unterseite die Tracking-Codeschnipsel manuell durch Web-Entwickler hinzugefügt, reduziert der Tag Manager nun diese Arbeit um ein Vielfaches und öffnet diese Thematik damit einer breiteren Masse. Statt mehrere einzelne Codes zu implementieren, erfordert der Tag Manager nur noch eine einmalige Änderung am Quellcode.

Der Code macht den Unterschied

Der Google Tag Manager trennt die Implementierung des Tracking von HTML und JavaScript und beschleunigt so die internen Prozesse, da viele Tätigkeiten ohne umfangreiche Programmierkenntnisse durchgeführt werden können.

Der Code lässt sich wie folgt implementieren:

Dieses JS-Code-Snippet gehört in den <head>

<!-- Google Tag Manager --> <script>(function(w,d,s,l,i){w[l]=w[l]||[];w[l].push({'gtm.start': new Date().getTime(),event:'gtm.js'});var f=d.getElementsByTagName(s)[0], j=d.createElement(s),dl=l!='dataLayer'?'&l='+l:'';j.async=true;j.src= 'https://www.googletagmanager.com/gtm.js?id='+i+dl;f.parentNode.insertBefore(j,f); })(window,document,'script','dataLayer','GTM-XXXX');</script> <!-- End Google Tag Manager -->

Und das ist der <noscript>Teil mit iframe

<!-- Google Tag Manager (noscript) --> <noscript><iframe src="https://www.googletagmanager.com/ns.html?id=GTM-XXXX" height="0" width="0" style="display:none;visibility:hidden"></iframe></noscript> <!-- End Google Tag Manager (noscript) -->

Weitere technische Informationen erhalten Sie auch hier:

https://developers.google.com/tag-manager/quickstart

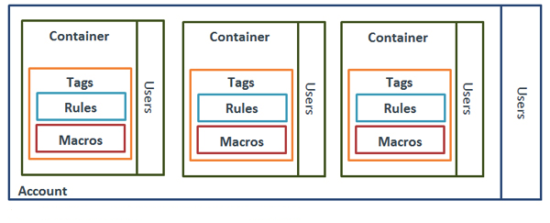

Der Aufbau des Google Tag Manager

Anschließende Änderungen kann der Seitenbetreiber nun ohne aufwändige Anpassungen selbst erledigen. Ein weiteres Plus ist die Google-typische, nutzerfreundliche Oberfläche, auf der alles zentral verwaltet und gesteuert werden kann. Schnell & Effizient.

Die Verflechtung der wenigen Elemente im Google Tag Manager werden anhand der Grafik deutlich. Der Nutzer kann je nach Rechteverwaltung auf gesamte Accounts oder einzelne Container zugreifen. Ein Container ist bspw. einer Webseite zugeordnet und regelt in sich geschlossen Tags, Trigger (Regeln) und Variablen (Makros).

Was ist ein Tag?

Ein Tag ist ein Code-Schnipsel, der Informationen an Dienste von Dritten übermitteln kann.

Tags können genutzt werden um Informationen zu senden, sie definieren also WAS gemessen wird (z.B. “Formular gesendet”). Der Tag Manager integriert die Code-Schnipsel in die Webseite.

Was steuert ein Trigger im Google Tag Manager?

Eigentlich ganz einfach: die Regel legt fest, unter welchen Bedingungen ein Tag ausgelöst wird. Dies kann ein Seitenaufruf, ein Klick oder eine definierte Zeitspanne sein. Die Regel wird auch Trigger genannt.

Was sind Makros?

Makros – auch Variablen genannt – beschreiben die Daten innerhalb der Tags und Regeln genauer. Und ermöglichen auf einer gesonderten Ebene Variablen zu definieren. Dafür gibt es schon Vorlagen oder man kann sie frei definieren. Beispielsweise lässt sich die Google-Analytics-ID als Makro anlegen und so auf mehrere Seiten übertragen.

Was ist ein Container im Google Tag Manager?

Alle Tags im Tag Manager bilden zusammen einen Container. Dieser Container erhält eine eindeutige ID und wird über ein bereitgestelltes Container-Snippet auf allen Seiten Ihrer Webseite eingefügt. Durch das komfortable Tag-Management im Dashboard können bestehende Tags und Container einfach kopiert und auf andere Webseiten übertragen werden. Dies ist hilfreich wenn Sie z.B. mehrsprachige Länder-Webseiten verwalten.

Dabei kann der Tag Manager sein Hauptvorteil ausspielen – die Zeitersparnis bei der Pflege von großen Webseiten. Wurde der Container einmalig implementiert, werden die Inhalte (also die Tags) durch den Webseitenbetreiber beliebig verändert und gesteuert ohne dabei auf tiefgreifende technische Kenntnisse zurückgreifen zu müssen.

Welche Dienste werden vom Google Tag Manager unterstützt?

Kurz gesagt: viele – Tendenz steigend.

Nach der Installation hat man sofort Zugriff auf eine gute Auswahl fertiger Tag-Vorlagen. Die Bandbreite deckt gängige Lösungen bereits ab: Ob Tags zu Webanalyse-Werkzeugen, Heatmaps, Social Media, Konversion und natürlich ist auch das Google-Portfolio verfügbar.

Eine Liste der Vorlagen bzw. der unterstützten Tags gibt es hier.

Welche Vorteile bietet der Google Tag Manager?

- Zentrale Verwaltung von Codes

- Entlastung der IT + Webmaster

- übersichtliche Struktur und sauberer Quellcode der Webseite

- Durch die Nutzung der Container verbessert sich die Ladezeit der Webseite

- Benutzerfreundliche Oberfläche

- Große Anzahl vorkonfigurierter Codes

- Regel und Trigger wählen – fertig

- Umfangreiche Konfigurierbarkeit

- individuelle Erstellung eigener Codes

- Tags, Regeln und Variablen sind beliebig kombinierbar

- Hierarchien lassen sich anlegen (zB Vorrang für Google Analytics-Tag)

- Vorschaumodus

- Möglichkeit der Funktionsprüfung und Debugging von Tags

- Simulation der aktuellen Container-Konfiguration auf der Seite durch den Tag Manager

- automatische Überprüfung der Tag-Einbindung

- Versionsbasierte Dokumentation

- Versionshistorie der Container und Tags wird transparent gespeichert

- Welches Teammitglied einen Tag erstellt hat oder Änderungen vorgenommen hat, ist in der Übersichtsdarstellung sofort ersichtlich

- Wiederherstellung einer früheren Version ist möglich

Grenzen des Google Tag Managers

- Die Anzahl der sofort nutzbaren Tags ist überschaubar. Die Erstellung eigener Tags setzt Grundkenntnisse in HTML voraus und je nach Komplexität auch JavaScript.

- Besondere Anforderungen an Tags und die Einbindung von weiteren Diensten erreichen schnell die Grenzen des Marketers und erfordern weitergehende Programmierfähigkeiten.

- Die Möglichkeiten Änderungen in den Tags selbst umzusetzen, umgeht möglicherweise Qualitätssicherungs-Prozesse der IT und bergen Fehlerpotenzial.

- Nutzen Sie andere Tools abseits des Google-Portfolios, z.B. zur Webanalyse oder Monitoring, müssen Sie entscheiden ob es für Sie nicht zu aufwändig ist, die Tags im Google Tag Manager zu pflegen. Gerade im Bereich der Marketing-Plattformen gibt es hier Lösungen, die bereits einen integrierten Tag Manager besitzen.

- Die Anbindung an “Nicht-Google”-Analytics-Produkte ist standardmäßig nicht gewährleistet und muss individuell programmiert werden möchte man bspw. Sitecore Analytics oder Adobe Analytics mit den gewonnen Datensätzen versorgen.

- Eine rollenbasierte Rechtevergabe ist nicht vorhanden, um bspw. der Marketing-Abteilung das publizieren auf einer Testseite zu ermöglichen – die letztendliche Veröffentlichung aber einer übergeordneten Hierarchieebene zuzuweisen.

Fazit

Dieser erste Überblick soll nur einen ersten Eindruck von den Nutzungsmöglichkeiten des Google Tag Manager geben. Zusammenfassend macht der Tag Manager vor allem Sinn, wenn auf den eigenen Webseiten ein umfassendes Tracking eingesetzt werden soll und dabei auf Tools von Google oder Drittanbieter zurückgegriffen werden soll.

Die wesentlichen Stärken sind dabei die Benutzerfreundlichkeit, keine erforderlichen Programmierkenntnisse und die Ressourcenersparnis.

In diesem Einführungsvideo von Google können Sie sich eine Zusammenfassung der Anwendung und Funktionen des Tag Manager anschauen: Zum Video

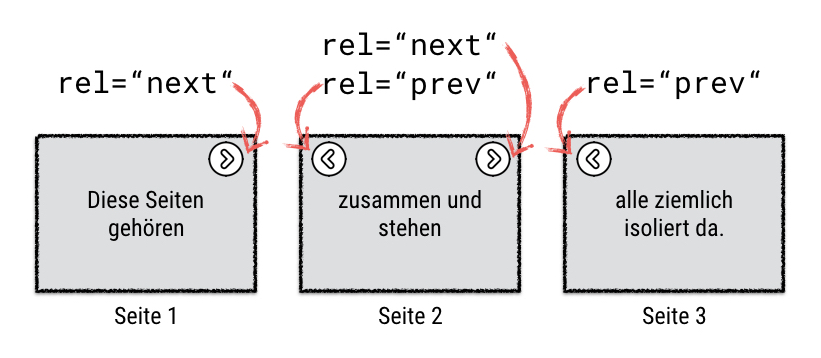

SEO: Paginierung für Onlineshops und inhaltsreiche Seiten

Onlineshop-Betreiber kennen das Problem: Produktkategorieseiten beinhalten oftmals viele Produkte, die über mehrere Seiten verteilt dargestellt werden.

UPDATE: Google hat bekannt gegeben, dass die Auszeichnung mit rel=“prev“ und rel=“next“ nunmehr kein Indexierungssignal darstellt.

Spring cleaning!

— Google Webmasters (@googlewmc) 21. März 2019

As we evaluated our indexing signals, we decided to retire rel=prev/next.

Studies show that users love single-page content, aim for that when possible, but multi-part is also fine for Google Search. Know and do what's best for *your* users! #springiscoming pic.twitter.com/hCODPoKgKp

Ohne weiteres Zutun indexieren die Suchmaschinen diese Seiten separat und erkennen hier doppelten Inhalt (“duplicate content”).

Mit ein paar Handgriffen zeigen wir, wie dieses Problem vermieden werden kann.

Alles auf einer Seite: Bietet sich eine Gesamtansicht an?

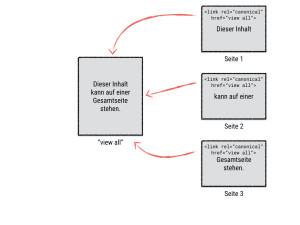

Zuallererst sollten Sie sich die Frage stellen, ob Sie Ihren Besuchern eine “view-all”-Seite anbieten möchten, d. h. alle Produkte – oder besser: alle Elemente, die normalerweise über mehrere Seiten verteilt dargestellt werden – finden Sie dann auf einer Gesamtseite wieder.

Vorteil: Die paginierten Seiten 1 bis n verweisen über den sogenannten canonical-Tag auf die Seite, auf der die Inhalte zusammengeführt werden. Über einen canonical-Tag teilen Sie den Suchmaschinen mit, wie diese mit (weitgehend) identischen Inhalten verschiedener Seiten umgehen soll. Durch die Angabe verweisen Sie auf eine Orginalressource bzw. URL .

Nachteil: Was bei einem mehrere Seiten langen News-Artikel, der vorzugsweise aus textlichem Inhalt besteht, charmant klingt, stößt bei der Produktkategorieseite eines Onlineshops mit hunderten Artikeln samt Produktbildern auf das Problem langer Ladezeiten. Da Latenzen ein Rankingfaktor sind, hört bei Google der Spaß bei Ladezeiten jenseits von drei Sekunden schnell auf.

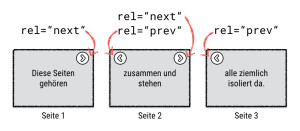

Ohne Gesamtansicht: Inhalte auf mehrere Seiten verteilt

In solchen Fällen ist eine “view-all”-Page nicht sinnvoll. Hier empfiehlt es sich, alle Folgeseiten, also die Seiten 2 bis n (n=letzte Seite) als ergänzende oder weiterführende Seiten zu kennzeichnen. Sie teilen der Suchmaschine mit, dass die Seiten 1 bis n zusammengehören, also im Grunde als „Kapitel“ in das Inhaltsverzeichnis aufgenommen werden sollen.

Die Auszeichnungen erfolgen im <head> Bereich des Markup. Auf der ersten Seite teilen Sie der Suchmaschine über ein <link> Element mit, dass es weitere, ergänzende Seiten gibt:

<link rel=”next” href=”seite-2.html”>

Auf der zweiten bis vorletzten Seite (Kompontentenseiten) definieren Sie die vorige und die nachfolgende Seite:

<link rel=”prev” href=”seite-1.html”>

<link rel=”next” href=”seite-3.html”>

Auf der letzten Seite reicht der Hinweis auf die vorige Seite (eine nächste Seite gibt es ja nicht):

<link rel=”prev” href=”seite-n-1.html”>

Ergänzend soll verhindert werden, dass die Seiten 2 bis n in den Index der Suchmaschinen aufgenommen werden (die Linkkraft der Produkte hingegen soll behalten werden). Dazu bedienen Sie sich folgenden Elements:

<meta name=”robots” content=”noindex, follow”>

Bitte achten Sie darauf, dass die erste Seite ganz regulär indexiert werden darf:

<meta name=”robots” content=”index, follow”>

Zusätzlich zu rel=”prev” und rel=”next” lässt beispielsweise Zalando die Komponentenseiten (Folgeseiten) via canonical-Tag auf die kanonische URL zeigen. Das sieht dann in etwa so aus:

<link rel="canonical" href="seite-1">

Im href-Attribut sind übrigens relative und absolute Pfadangaben erlaubt.

Viele Wege führen nach Rom

Wie oftmals im Online-Marketing gibt es auch in Sachen Paginierung unterschiedliche Herangehensweisen.

So verzichten einige Online Shops auf den Einsatz von rel=”prev” und rel=”next” und verweigern den Suchmaschinen über die Meta-Robots die Indexierung der Komponentenseiten.

Welche Variante Sie auch bevorzugen: Das Hauptaugenmerk sollte darauf liegen, doppelten Inhalt zu vermeiden. Ob Sie dies nun mit einer „view all“ Seite oder über die Angaben im <head> Bereich Ihrer Seite lösen, hängt nicht zuletzt auch vom Kontext ab: Verteilen sich vorwiegend textliche Inhalte über mehrere Seiten, kann eine Gesamtseite – auch unter Usabilty-Gesichtspunkten – ideal sein. Bei bildlastigen Produktkategorieseiten sind rel="prev" und rel="next" sicherlich die bessere Wahl.

Hier sei noch angemerkt, dass nicht sicher ist, ob andere Suchmaschinen wie bpsw. Bing die Attributswerte „next“ und „prev“ in gleicher Weise interpretieren wie Google. Google selbst hat bereits im September 2011 erklärt, die Paginierung von Seiten mit rel=“next“ und rel=“prev“ zu unterstüzen.

Google Disavow Tool zur Abwertung von Links

Um das sogenannte Disavow Tool ranken sich mittlerweile die verschiedensten Geschichten. Das Linkentwertungstool aus dem Hause Google wird mittlerweile auch als Druckmittel verwendet, weil nach wie vor einige Website-Betreiber dem Irrglauben unterliegen, dass mithilfe dieses Tools Websites in ihrer Wertigkeit abgestuft werden können.

Es gibt verschiedene Kriterien anhand dessen Google Websites eine Wertigkeit vergibt, natürlich verrät Google nicht, welche Kriterien mit welcher Gewichtung am Ende tatsächlich in den Algorithmus einfließen. Allerdings weiß wohl jeder Webseitenbetreiber, spätestens seit dem sogenannten Pinguin Update, dass Backlinks nach wie vor einen relevanten Faktor darstellen, schlechte Backlinks aber zur Abwertung von Websites führen können.

Google ist bemüht Websites zu bewerten und diese anhand der Bewertung in den Suchergebnissen zu positionieren. Darein fließen auch Backlinks, je nach Qualität, mit positiver wie auch negativer Auswirkung in das Ranking ein. Im Zuge verschiedener Algorithmus-Updates und Erweiterungen hat Google gezeigt, dass Websites, deren Links manuell aufgebaut werden, erkannt werden und dem entsprechend auch abgewertet werden können. Zeitgleich stellt Google das sogenannte Disavow Tool zur Verfügung, mit dem Links für ungültig erklärt werden können.

Das Disavow Tool, wird eingesetzt wenn…

Es gibt verschiedene Gründe, aus denen das Disavow Tool zum Einsatz kommen kann. Beispielsweise kann ein Konkurrent auf die Idee kommen, eine Website durch Spamlinks in die ewigen Jagdgründe schicken zu wollen. Ferner kann der Websitebetreiber auch eigene Links, auf schwachen und nicht relevanten Seiten, aufgebaut haben. Die Gründe sind unterschiedlich, allerdings die Ursache in der Regel identisch.

Aktuell erhalten viele Blogger entsprechende Nachrichten, dass Links, die in Kommentaren gesetzt wurden, unter Androhung des Einsatzes des Disavow Tool schleunigst zu entfernen sind. Der Irrglaube, dass mit dem Disavow Tool anderen Websites geschadet werden kann, existiert eigentlich schon seit der ersten Version des Tools. Doch das Disavow Tool dient lediglich dazu, der Suchmaschine Google mitzuteilen, dass in der Vergangenheit ein Fehler gemacht wurde und eventuell Links manuell aufgebaut wurden oder andere Personen diese aufgebaut haben. Links werden somit als nicht gültig erklärt – eine Website wird dadurch nicht abgewertet, das wäre auch für die organische Suche mehr als fatal, auch wenn die bezahlten Ergebnisse von Jahr zu Jahr stärker in den Fokus rücken.

Funktionsweise des Disavow Tool

Die Funktionsweise des Disavow Tool ist denkbar einfach: Zu allererst gilt es die Links zu identifizieren, die den Schaden verursacht haben. Diese müssen einfach in einer CSV-Datei oder Textdatei untereinander aufgeführt werden.

Im Anschluss muss natürlich das Online-Tool unter https://www.google.com/webmasters/tools/disavow-links-main aufgerufen werden. Im nächsten Schritt muss die entsprechende Domain, die vorher in den Google Webmaster Tools verifiziert wurde, ausgewählt werden.

Nachdem die gewünschte Domain, deren Links als ungültig eingestuft werden sollen, ausgewählt wurden, muss natürlich die vorgefertigte Text-Datei oder CSV eingebunden werden. Im Anschluss kann die Datei über den Button „Senden“ an Google übermittelt werden.

Nun heißt es abwarten, bis Google die Ungültigkeitserklärung übernimmt und die vermeintlich negativen URLs aus der Berechnung entfernt.

Mit dem Einsatz des Disavow Tool schadet man nicht der Website, welche auf die eigene Website verlinkt, sondern sorgt lediglich dafür, dass die Links nicht mehr in die Bewertung der Website mit einfließen. Google ist anhand seines Algorithmus selbst in der Lage die Website, von der auch der Link stammt, zu bewerten.

Warum die Optimierung Ihres Google Places-Profils immer wichtiger wird

Internet-Nutzer suchen über die Google Suche immer häufiger Anbieter aus ihrer näheren Umgebung (local search), um den passenden Dienstleister für ihr Anliegen zu finden. Fündig werden sie in der „normalen“ Google Suche und bei Google Maps.

Daher ist es gerade für kleine und mittelständische Unternehmen, aber auch für größere Unternehmen mit mehreren lokalen Zweigniederlassungen wichtig, sich mit einem Eintrag in Google Places, dem Branchenverzeichnis von Google, zu beschäftigen, um optimal bei Google gefunden zu werden.

Sieht Google PR-Meldungen und Pressemitteilungen als unerlaubte SEO-Maßnahme?

Google hat letzte Woche seine Webmaster Rules für Linktauschprogramme geändert, wie SiliconvalleyWatcher Tom Foremski bei ZDnet schreibt. Tom sieht in den Änderungen besonders einen Angriff von Googles auf PR-Agenturen. Ich denke, seine Erkenntnisse sind weit reichender und lassen sich auf jede Webseite übertragen, die Inhalte verbreiten und Traffic kanalisieren und Besucher anziehen will.

Google hates any other business that promotes other businesses because Google wants that money.

Das ist seine Kernaussage – nicht ganz wörtlich übersetzt: Google wird langfristig gegen alle Unternehmen vorgehen, die andere Unternehmen online promoten. Weil Google diese Kohle selber haben will. Und weiter heißt es, dass Pressemitteilungen eine Form von SEO sei. Ob die PR-Industrie diese Ansicht teile oder nicht sei dabei irrelevant, weil Google hier die Definition, den Umgang damit und etwaige Sanktionen festlegt.

Was ist denn jetzt eigentlich genau das Problem mit Pressemitteilungen?

Bis heute hat Google weder eigenes Marketing betrieben, um sich als beste Suchmaschine zu positionieren, noch hat Google einen Marketing-C-Level im Organigramm stehen und – wie Foremski feststellt – ist Google sehr stolz darauf, dafür zu sorgen, dass sie zur Selbststeuerung des Internet beitragen, indem automatisch immer die besten Suchergebnisse nach oben kommen. Das funktioniert natürlich nur so lange, wie (verdeckt) bezahlte Werbeangebote nicht die Ergebnisse verfälschen.

Soweit zur Google-Romantik und dass es qualitativ hochwertige Suchergebnisse bieten will. Auf der anderen Seite der Medaille steht ja noch etwas anderes, sehr nachvollziehbares: Google will AdWords verkaufen. Je besser die inhaltlichen Suchergebnisse, desto besser funktionieren auch die AdWords. Doof, wenn Agenturen Budget von AdWords abziehen, dass dann in bezahlte Beiträge fließt, die wiederum die Suchergebnisse verschlechtern. Quasi eine Lose:Lose-Situation für Google.

Früher bedeutete Qualität v.a. Anzahl von Links auf eine Seite. Je mehr unabhängige Links, desto höher rankte die Seite. Dann kam das Panda-Update und damit der stärkere Fokus auf Qualität. Das bedeutete: Bezahlte Links und SEO-Tricks wurden ausgesiebt, Usability und schnelle Ladezeiten trugen zur Qualitätssteigerung und damit zur Verbesserung des Suchrankings einer Seite bei. Die reine Anzahl an Backlinks wurde zum ersten Mal in den Hintergrund gedrängt.

Mit dem Penguin-Update und Penguin 2.0 wurde der Fokus noch weiter auf externe Linkqualität, Link- und Ankertexte innerhalb von Webseiten gelegt sowie auf den strukturierten Aufbau von Webinhalten und deren Verbreitung durch Social Signals – hierzu hat ein Kollege eine 5-teilge Artikelserie geschrieben.

Was machen PR-Agenturen in Googles Augen falsch?

Sie verwässern und verschlechtern die Suchergebnisse durch gezielt platzierte Gast-Beiträge, bezahlte Beiträge in Blogs, Advertorials, bezahlten Twitter- und Facebook-Shares, gekauften Followern etc. Hier die drei neuen Punkte, die der Google Webmaster Doku hinzugefügt wurden:

- Links mit optimiertem Ankertext in Artikeln oder Pressemitteilungen, die auf anderen Websites verteilt sind. Beispiel:

Das Angebot an Trauringen ist riesengroß. Wenn Sie eine Hochzeit planen, suchen Sie sicher nach dem besten Ring. Sie müssen auch Blumen kaufen und einHochzeitskleid. - Artikel-Marketing im großen Stil oder das Posten von Kampagnen als Gast mit Ankertextlinks, die viele Keywords enthalten

- Textanzeigen oder native Werbung, wo Artikel mit Links, die PageRank weitergeben, bezahlt werden

Für mich persönlich sind besonders die Wortwiederholungen ein Graus. Der gleiche Abschnitt zum Trauring-Beispiel aus den englischen Webmastertools macht das mit 3 mal „wedding“ und 2 mal „ring“ auf insgesamt 32 Wörter deutlicher:

- There are many wedding rings on the market. If you want to have a wedding, you will have to pick the best ring. You will also need to buy flowers and a wedding dress.

Sie merken schon: Man merkt beim Lesen einfach selber, wann man es mit der Optimierung übertrieben hat 😉

Das Beispiel aus der Dokumentation zu „Forumkommentare mit optimierten Links im Post oder in der Signatur“ treibt es auf die Spitze:

- Danke für die tollen Infos!

– Paul

Pauls Pizza Berlin Pizza beste Pizza Berlin

Haben Sie also ein gutes Auge darauf, was Ihnen Ihre Agentur genau anbietet und in Ihrem Namen veröffentlicht – Letztendlich straft Google voraussichtlich v.a. den Kunden einer Agentur ab.

Betrifft das Problem nur PR-Agenturen?

Natürlich betrifft es im Kern- und Tages-Geschäft PR-Agenturen deutlich stärker als Unternehmen, die sich rein auf eigene Inhalte konzentrieren können. Aber auch hier kann es nicht schaden, für das Thema zu sensibilisieren und regelmäßig einen Blick in die Dokumentation von Googles Webmastertools zu werfen.

Doch die neuen Regeln werden mit ziemlicher SIcherheit auch auf bestehenden Content angewendet. Daher liegt es im eigenen Interesse die bestehenden Inhalte zu prüfen und ggf. nachzusteuern.

Tom Foremski malt für PR-Agenturen in den USA sehr, sehr schwarz, sieht sie in direkter Konkurrenz zu Google und stellt sogar in den Raum, Agenturen könnten von ihren Kunden verklagt werden, wenn durch die neuen Regeln nachträglich ein Schaden entsteht. Doch auch die zukünftige Arbeit wird nicht unbedingt erleichtert, wenn das Penalty-Damoklesschwert über jeder bezahlten Promotion schwebt. Die meisten PR-Profis in den Kommentaren des ZDnet-Artikels sind da deutlich entspannter.

Als jemand, der regelmäßig mit Google-Mitarbeitern aller Hierarchiestufen spricht gibt Tom den Rat: „Optimiert für Eure eigenen Kunden, damit die Suchmaschinen sich selber optimieren können“. Da ist durchaus etwas dran. Je besser die Webinhalte sind und je weniger Manipulationsversuche unternommen werden, desto mehr kann sich auch der Suchmaschinenanbieter auf sein Kerngeschäft konzentrieren, statt Zeit und Ressourcen in ein Katz-und-Maus-Spiel investieren zu müssen.

Meine persönliche Einschätzung ist, dass Google in den kommenden Monaten noch deutlich härtere Bandagen anlegen wird. Oder formulieren wir es so: Die Bandagen werden verfeinert, wenn nämlich der große Wust an massenhaften Presseportalmeldungen in den Griff bekommen wurde.

Denn wie gesagt: Es sieht jeden als Konkurrenten, der AdWords-Budget angreifen könnte.

Muss man mit Gastbeiträgen und Linktausch vorsichtiger werden?

Massive Kollateralschäden für alle Webseitenbetreiber sind derzeit eher nicht zu befürchten. So lange Beiträge einen Mehrwert liefern und nicht massiv in großer Zahl Links aufgebaut werden, sollte sich die Gefahr für einzelne Websitebetreiber in Grenzen halten wie SEOsweet hier auch im letzten Abschnitt beschreibt. Google geht es darum, systematische Massenverbreitung von Inhalten zu verhindern, deren einziger Zweck es ist, gezielt Suchergebnisse zu beeinflussen. Die Internetkapitäne raten dazu, die entsprechenden Methoden maßvoll einzusetzen.

Bleibt nur zu hoffen, dass Google gut unterscheiden kann, wo ein eigener und eigenständiger Beitrag aufhört und eine Pressemitteilung anfängt.

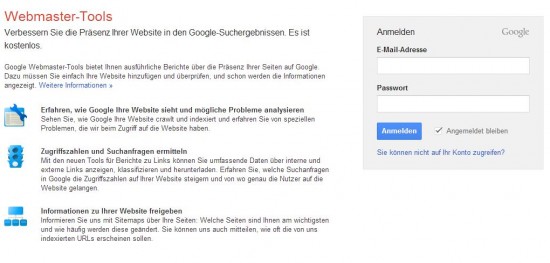

Die Google Webmaster Tools – das Warum

Um die wertvollen Daten der Google Webmaster Tools auch nutzen zu können, bedarf es lediglich der Erstellung eines Nutzerkontos bei Google – mithilfe des Nutzerkontos stehen mehrere Dienste wie auch Google Analytics dem Kontoinhaber zur Verfügung.

Mittlerweile unterteilen sich die Google Webmaster Tools in die Bereiche Konfiguration, Status, Zugriffe, Optimierung und Google Labs. Nebst diesen Bereichen gibt es ein einleitendes Dashboard, das den aktuellen Status zu Crawling-Fehler, Suchanfragen und der Sitemap widerspiegelt.

Der signifikanteste Grund, warum der Einsatz der Google Webmaster Tools für jeden Anwender Sinn macht, ist dass die Daten von Google zum einen relativ aktuell sind und zum anderen direkt vom Marktführer im Bereich der Suchdienste stammen. Damit hat der Webseitenbetreiber die „vertrauenswürdigste“ Quelle als Lieferant für Daten über die eigene Webseite.

Bedenken sollte der Anwender aber auch, dass die Daten, die von Google kommen, grundsätzlich begrenzt sind und Google nicht sämtliche Informationen, die uns als relevant erscheinen, anzeigen wird. Zwar verbietet Google die Optimierung (bzw. Suchmaschinenoptimierung) von Webseiten und Inhalten nicht, wird dies aber auch nur bis zu einem gewissen Rahmen unterstützen (Google Webmaster Richtlinien).

Warum sollten die Google Webmaster Tools genutzt werden?

Unabhängig davon ob SEO Agentur, Unternehmen oder einfacher Hobby-Webmaster, ein jeder hat die Möglichkeit, die Google Webmaster Tools kostenlos zu nutzen.

Vorweg gesagt, die Google Webmaster Tools stehen nicht in Konkurrenz zu professionellen Tool-Anbietern wie zum Beispiel der Sistrix Toolbox, Searchmetrics Essentials, Searchmetrics Suite oder auch den Link Research Tools. Dennoch bietet Google mit dem hauseigenen Dienst eine grundlegende Übersicht über relevante Daten hinsichtlich der eigenen Website.

Anhand der gewonnen Daten können Probleme, Fehler und Einschränkungen diagnostiziert werden – zudem benachrichtigt Google den Webseitenbetreiber direkt über die Google Webmaster Tools im Falle von Problemen und ungewöhnlichen Veränderungen (signifikanter Anstieg der Suchanfragen, Malware, unnatürlicher Linkaufbau).

Bisherige Artikel zu den Google Webmaster Tools im comspace Blog

- Google Webmaster Tools: Crawling-Geschwindigkeit

- Google Webmaster Tools: Sitelinks abwerten

- Google Webmaster Tools: Geografische Zielausrichtung

- Google Webmaster Tools: XML-Sitemap

- Google Webmaster Tools: Dashboard und Nachrichten

- Exkurs: Beschleunigte Indexierung durch die Google Webmaster Tools

- Exkurs: Website Geschwindigkeit: Was ist langsam und vor allem was ist schnell?

- Die Google Webmaster-Tools: Welche Dienste können sie leisten?

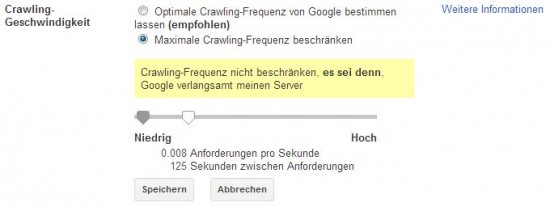

Google Webmaster Tools: Crawling-Geschwindigkeit

Das Crawling bezeichnet in erster Linie den Vorgang, mit dem veränderte und neue Inhalte bzw. Seiten ermittelt werden, um diese später in den Suchindex von Google aufzunehmen. Suchmaschinen, vorzugsweise Google, besitzen eine Vielzahl von Crawlern (z.B. der Googlebot), die täglich damit beschäftigt sind, so viele Inhalte wie möglich zu untersuchen.

Der Googlebot und die Crawling-Geschwindigkeit

Dieser Googlebot besucht mehrmals am Tag die eigene Webseite, in der Regel optimiert dabei Google selbst die Häufigkeit des Besuchs in Abhängigkeit der Größe einer Webseite und natürlich der gewohnten Schreibfrequenz. Dies bedeutet: sofern eine Webseite in der Regel mehrmals am Tag neue Inhalte veröffentlicht, wird diese im Vergleich zu einer kleinen Webseite mit wenigen inhaltlichen Änderungen im Monat häufiger besucht.

Wem dennoch die Besuchshäufigkeit des Googlesbots zu hoch erscheint, z.B. aufgrund des entstehenden Traffics / Datenvolumens, der kann diesen über die Google Webmaster Tools regulieren und somit eingrenzen.

Google selbst empfiehlt, die Crawling Geschwindigkeit nur in absoluten Ausnahmefällen, beispielsweise wenn dadurch die Geschwindigkeit/Performance des Servers deutlich verlangsamt wird, zu verändern.

Grundsätzlich sollte die Häufigkeit des Crawlings einer Webseite nicht verändert werden und der Rhythmus sollte seitens der Suchmaschinen bestimmt werden – schließlich möchten neue und bearbeitete Inhalte zeitnah in den Index aufgenommen werden und optimaler Weise direkt von potentiellen Besuchern und Kunden gefunden werden.

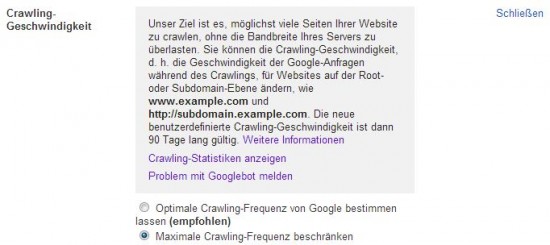

Probleme mit dem GoogleBot melden

Eine Anpassung der Crawling Geschwindigkeit ist in der Regel 90 Tage gültig und wird im Anschluss auf den Ausgangswert zurückgesetzt. Sollten tatsächlich durch den Googlebot signifikante Probleme auftauchen, so besteht auch die Möglichkeit die Probleme mit dem Googlebot zu melden (siehe Links zu weiteren Informationen in obiger Grafik).

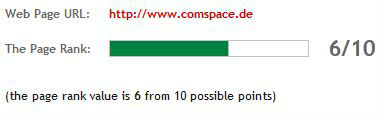

Google PageRank Update (Februar 2013)

Es ist allem Anschein nach wieder soweit – Google spielt ein Update des sichtbaren PageRanks ein.

Einst galt der Google PageRank (Algorithmus) als das wichtigste Kriterium, um die Qualität von Websites bestimmten zu können. Die Grundlage war zugleich die Geburt der Suchmaschine Google im Jahre 1998.

Die Aufgabe des PageRank Algorithmus war bzw. ist es, die Qualität von Internetseiten anhand der Anzahl von Backlinks zu bestimmten und Webseiten anhand der daraus resultierenden Gewichtung in den Suchergebnissen zu positionieren. Der sichtbare Pagerank stellt sich in einer Skala von 0 bis 10 dar.

Während vor Jahren noch diverse Webseitenbetreiber mit Popcorn und ausreichend Flüssignahrung darauf warteten, dass sich der Pagerank verbessert – so hat die Popularität deutlich abgenommen.

Warum der PageRank an Bedeutung verloren hat?

Im Verlauf der letzten 15 Jahren hatten Suchmaschinen wie Google Inc. ausreichend Zeit, nebst dem PageRank weitere Algorithmen (z.B. Google Panda Update), Filter und Extensions zu entwickeln, die zusätzlich die Wertigkeit und Qualität jener Webseiten, die einst nur durch den PageRank in den Suchergebnissen positioniert wurden, anhand von weiteren Kriterien und Muster bestimmen.

Das heißt, der Algorithmus von Suchmaschinen wie Google besteht nicht mehr aus einem Bewertungskriterium, sondern aus vergleichsweise vielen Kriterien, Mustern und Berechnungen. Zum Beispiel ist die Termgewichtung (w = WDF * IDF), die auf www.online-marketing.net sehr ausführlich von Karl Kratz beschrieben wird, ein sehr spannendes Thema.

Ich bin dennoch neugierig und möchte meinen PageRank messen?

Es gibt viele Möglichkeiten, den PageRank zu ermitteln. Mittlerweile gibt es für jeden Browser ausreichend Extensions / Plugins die eine Abfrage erlauben. Alternativ gibt es auch Tools, wie von www.seo-ranking-tools.de, mit denen der PageRank Online abgefragt werden kann.