3 Tage re:publica rekapituliert man nicht mal eben so 🙂 Ich kenne keine Konferenz oder Barcamp, die ihre Gäste vergleichbar fordert, was Themenvielfalt, Konferenz-Running-Gags und die mit nach Hause genommenen Inspirationen und Informationen angeht. Das schöne ist aber, dass fast alle Vorträge als Video verfügbar sind und viele Besucher und Vortragende der re:publica nachträglich Zusammenfassungen zu ihren Lieblingsvorträgen veröffentlichen. Gut einen Monat habe ich nun gewartet um die spannendsten Vorträge sowie die Reaktionen darauf hier zusammen getragen und einen Einblick zu bieten, warum wir auf der re:publica waren und v.a. was wir für comspace von dort mitgebracht haben.

„Die re:publica hat eben auch mehr von einem Business-Festival als von einer normalen Konferenz.“

Mit diesen Worten leitete Mitorganisator Andreas Gebhard die #rp13 ein (auf seinem Blog gibt es eine lesenswerte re:publica Making-Of Serie). So wie ich mich in jungen Jahren auf Festivals auch immer daran hielt, die Bands zu sehen, die ich mir vorgenommen hatte, habe ich mich dieses Jahr zu 90% an meinen vorher festgelegten Vortrags-Plan gehalten 🙂 Trotzdem war zwischen den Vorträgen noch genug Zeit für das Netzwerken, was auf der rp13 eher einem Klassentreffen gleicht.

Neben all den Startups und dem Schwerpunktthema Afrika, Kulturthemen, netzpolitischen Diskussionen und einem durch meinen Lieblings-SfiFi-Autoren Cory Doctorow signierten Kindle der auch für mein persönliches Lieblingszitat verantwortlich war:

„I sat down with information.We talked.It confessed it doesn’t want to be free, it wants us to stop anthropomorphizing it.“ #rp13 @doctorow

— Wortwert² (@megatrend) May 8, 2013

…sind vor allem für die Business-Hirnwindungen die folgenden Inhalte im Gedächtnis geblieben:

Hinweis: In diesem Beitrag sind überdurchschnittlich viele Links – v.a. auf Videoaufzeichnungen der re:publica Vorträge bei YouTube enthalten. Links deswegen, weil so viele eingebettete Videos Probleme mit der Browsergeschwindigkeit bei Ihnen als Leser verursachen können.

Machen! Das Web wird auf die eigenen Server zurück geholt

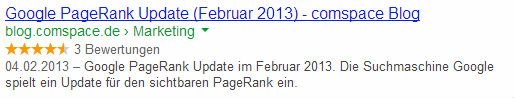

Sascha Lobo ist mit seinen Vorträgen auf der re:publica mittlerweile eine feste Größe mit ebenso fester Frisur. Hat er auf einer der vergangenen re:publicas noch dazu aufgerufen wieder mehr zu bloggen und weniger der fremd-verantworteten Kanäle wie Facebook, Tumblr, Twitter usw. zu nutzen, wurde er dieses Jahr deutlich konkreter.

Mit reclaim.fm haben Lobo und Felix Schwenzel eine erste Alpha-Version einer Lösung für WordPress vorgestellt, mit der sich digital hinterlassene Spuren wie Tweets, Instagram-Bilder, Facebook-Likes, Pinterest-Pins und wie sie alle heißen, auf einer eigenen WordPress-Plattform zusammen tragen lassen. Sowohl technisch als auch (urheber-)rechtlich sind bezüglich der Nutzung von reclaim.fm noch ein paar Fragen offen. Das System das v.a. aus einigen WordPress-Plugins und Scripten besteht, verspricht aber eine echte Arbeitserleichterung zu werden. Im Auge behalten! Die zweite und noch viel wichtigere Botschaft seines Vortrags war:

Machen!

Und wenn es ein längst überfälliges Logo für das Internet ist, das Sascha Lobo mit Stijlroyal entworfen hat. Die Weltkugel von einem Netz überspannt. Dargestellt durch zwei Klammern und eine Raute:

(#)

Kleines Update nach nun ungefähr 1 Monat: reclaim.fm wurde von manchen Nutzern erfolgreich installiert. Andere (inklusive mir) waren bisher noch nicht so erfolgreich, die Plugins und Skripte zum Laufen zu bringen. Ich bin gespannt, ob von Felix und Sascha oder jemand anderem noch eine Weiterentwicklung von reclaim.fm kommt.

Content Strategie

Einen der handfestesten Vorträge mit direktem Praxisbezug habe ich von Brigitte Alice gehört. Auch wenn es in Ihrem Workshop um Content Strategy bei NGO ging (also Nichtregierungsorganisationen wie bsw. dem Roten Kreuz), lassen sich viele Ihrer Vorschläge und Ansätze auch auf die Content Strategien im Business-Bereich übertragen. Insbesondere die umfangreiche und strukturierte Recherche zur Vorbereitung, übergehend in den Content Audit, die Erstellung eines Content Inventory und die Durchführung von Content Prototyping war sehr aufschlussreich.

CRM – Constituent Relationship Management

Im Anschluss zur Content Strategie ging es direkt weiter mit dem Thema CRM. Interessanterweise immer noch im Themenfeld NGO. Deswegen sprach Fabian Schuttenberg auch von Constituent Relationship und nicht Customer Relationship. Denn auch wenn im Umfeld von Wohltätigkeits- und Nichtregierungs-Organisationen auch Beziehungsmanagement betrieben wird, ist es eben etwas anderes, ob es sich um eine Kundenbeziehung oder die zu Spendern oder freiwilligen Unterstützern handelt. Die Engagement Ladder – scheint ein hilfreiches Tool zu sein, um festzulegen, welche Conversion-Ziele gesetzt werden sollen: Vom Interessierten zum Newsletter-Abonnenten. Vom Petitions-Zeichner zum zahlenden Spender.

Raus aus der Blase Internet

Gunter Dueck hat vor 2 Jahren bereits den damals meist beachteten Vortrag der re:publica 2011 gehalten. Dieses Jahr war er eine Spur sperriger unterwegs und hat uns ganze Menschenbilder erklärt. Einigermaßen greifbar wurde das, als er vom Ethnozentrismus sprach, der sich besonders auf solchen Konferenzen zeigt. Jeder der Anwesenden kann verstehen worum es geht. Es haben nicht alle die gleiche aber doch eine ähnliche Meinung und Vorstellung von der Welt – zumindest über die Relevanz der eigenen Themen. Darüber wird oft vergessen, dass das draußen vor der Tür des Konferenzsaals im „echten Leben“ oft ganz anders aussieht. Duecks Kernaussage lautete für mich: Wir sollten empathischer sein und über den Tellerrand unserer Web-Blase hinaus blicken.

Wie wird sich Arbeit in Zukunft verändern?

Wir sind always on und damit auch immer mit halbem Kopf bei der Arbeit. Maschinen nehmen uns immer mehr Arbeit ab oder lasen uns effektiver arbeiten. Ob es nun Tablets, Apps und mobile Computing für den Wissensarbeiter sind oder Roboter, ERP-Systeme und computergestützte Logistik in der Industrie 4.0. Der zweite re:publica Tag entwickelte sich für mich zu einem Tag unter dem Überthema Arbeit:

Los ging es mit Theresa Bückers Vortrag Der Montag liebt Dich. In dem sie einen kurzen Abriss über die moderne Arbeitskultur gab. Darüber, wie wir zufriedener bei und mit unserer Arbeit sein können. Warf die Frage auf, warum die aktuellen Innovationen in Technik und Kommunikation sich eigentlich nur schleppend am Arbeitsplatz durchsetzen. Gab Beispiele dafür wie Corporate Social Responsibility auch für gute Beziehungen und Freundschaften der Mitarbeiter zuständig ist wie aber auch darauf hin, dass Arbeitnehmer selbst in der Verantwortung sind, Ihre Bedürfnisse kund zu tun, um besser Leben und Arbeit miteinander zu verbinden. Klingt ein wenig poetisch – war es in Teilen auch. Ich empfehle den Vortrag einfach anzuschauen. Ausführlicher lässt sich der Vortrag bei goodplace und schulzekopp nachlesen. Sketchnotes hat den Vortrag skizziert.

Deutlich wissenschaftlicher ging es im Anschluss mit der Soziologin Jutta Allmendinger weiter. Sie hat Lebens(ver-)läufe, ihre Einflussfaktoren und die daraus resultierenden Veränderungen nicht nur für die Arbeits-Gesellschaft untersucht. Sondern auch zwischen den Geschlechtern. Dabei hat sie festgestellt, dass sich das Gesamtarbeitsvolumen von Frauen in den letzten 30 Jahren kaum verändert hat und die Arbeitsverteilung eher unter Frauen statt fand: Von Vollzeitstellen zu mehr Teilzeitarbeitsplätzen. Damit stellte sie die These auf, dass der Heiratsmarkt im Hinblick auf die sichere Rente für Frauen derzeit noch zielführender sei als der Arbeitsmarkt. Ausführliche Beiträge hierzu bei Katrin Roenicke und bei der Bundeszentrale für politische Bildung.

Der meiner Meinung nach beste Vortrag der #rp13: Das Ende der Arbeit

Dann folgte der meiner Meinung nach beste Beitrag der re:publica 2013 (deswegen hierzu auch das Video im Text) von Johannes Kleske – seit seinem Coverfoto auf der brand:eins auch gerne der Posterboy der Digital Natives genannt 😉

[iframe src=“http://www.youtube.com/embed/xPL0vKClCxM“ height=“315″ width=“560″ allowfullscreen=““ frameborder=“0″]

Viele unserer technischen Errungenschaften dienen vor allem einem Zweck: Uns möglichst viel Arbeit abzunehmen oder leichter zu machen. Vor allem körperliche. Derzeit macht Technologie mehr Arbeit überflüssig, als sie uns neue Arbeitsplätze schafft. Deswegen sprach Johannes Kleske über Das Ende der Arbeit und wie wir in Zukunft leben wollen. Johannes zeigt historische Beispiele wie die Bürger des antiken Athen sich mit Philosophieren und Politik beschäftigten, während die Arbeit – nunja – von Sklaven erledigt wurde. Heute könnte diese Erledigung von alltäglichen Aufgaben von Maschinen übernommen werden. Kritisch beäugt er, dass arbeitende Menschen durch Maschinen natürlich auch überwacht und kontrolliert werden und führt dabei ein „Armband“ an, das Mitarbeiter der Firma Tesco während der Arbeit tragen müssen und darüber gemonitort werden.

Eine detaillierte Ausführung von Johannes Session findet sich hier bei dailymo. Steffen Voss frag: Kann Arbeit enden? Antje Schrupp hat sehr spannende Beiträge in ihrem Blog dazu: Zunächst den von Johannes Vortrag angeregten Menschen, Maschinen und Arbeit. Im zweiten Beitrag beschreibt sie, warum manche immer arbeiten, sie aber eigentlich nie arbeitet.

An dieser Stelle möchte ich mal aus eigener Erfahrung betonen, dass wir bei comspace bereits eine Menge der in den oben erwähnten Ansätzen für moderne Arbeit anwenden, verinnerlicht haben und von unseren Chefs zugestanden bekommen. Seien es flexible Arbeitszeiten, Freiräume beim Arbeiten, gesunde Arbeitsplätze, Bildungsangebote usw.

Später am Tag ging es um einige Ergebnisse von Arbeit:

Autos und Mobilität

Dieter Zetsche – Daimler-Vorstandsvorsitzender (Sponsor der re:publica) wurde in einer rappelvollen Stage 1 von Martin Randelhoff interviewed und stellte sich im Anschluss einigen Publikumsfragen. Zetsche sprach über die Zukunft des Autos, autonome Fahrzeuge und das Daimler in dem Bereich bereits auf einem ähnlichen Stand wie Google ist, das vernetzte Auto und wie sich dadurch unsere Mobilität verändert. Genauso aber auch über die Integration von Social Media ins Auto und ob es Sinn macht, Facebook und Twitter während des Fahrens zu nutzen oder nicht. Eine Zusammenfassung des Interviews hat t3n und hier geht es zum Video des Interviews. Sehr empfehlenswert – zum einen, weil schon bemerkenswert ist, dass der CEO eines Konzerns wie Daimler die Re:Publica derart ernst nimmt. Zum anderen, weil interessant ist, wie die „klassische“ Industrie die aktuellen Veränderungen wahrnimmt, bewertet und mit ihnen umgeht.

Im Anschluss ging es mit einem weiteren Vortragenden aus dem Haus Mercedes-Benz weiter: Daimlers Zukunftsforscher Alexander Mankowsky hielt einen Workshop zu der Frage: „Vernetzte Mobilität – Erobert das Digitale die analogen Welten?“ – Dabei wurde klar, dass das autonome Fahren scheinbar die disruptivste und gleichzeitig ausgereifteste Technologie moderner Mobilität ist und in den nächsten 10 Jahren wohl für die meisten Innovationen sorgen wird. Alex Mankowksy erklärte, warum die Autorevolution fast 40 Jahre brauchte um richtig Fahrt aufzunehmen. Als Grund nannte er, dass zunächst die Infrastruktur mitwachsen musste: Straßen, Tankstellen, Verkehrsschilder, rechtliche Regelungen, Werkstätten und so weiter. Er zeigte Beispiele mittlerweile historischer Automobil-Innovationen, die heute aus unserem Leben nicht mehr wegzudenken sind und Innovationen die ohen Auto nie entstanden wären wie Vergnügungsparks bsw. Er gab Ausblicke auf Möglichkeiten, die sich durch selbstständig fahrende Autos ergeben: Vom Car-Sharing über Lieferdienste bis hin zu Dienstleistungen für Senioren. Bei Sketchnotes gibt es eine graphische Skizze des Workshop.

Am Rande:

In einem Workshop des Senders SWR3 kam uns die Erkenntnis: Auch Social Media Manager der öffentlich rechtlichen Sendeanstalten geben nur ungern konkrete Zahlen über Nutzer-Interaktionen in internaktiven Sendeformaten heraus.

Daten, Daten und nochmal Daten – Sammeln, Analysieren und draus lernen

Wir hatten das Thema Big Data gerade in unserem vorletzten Newsletter. Umso interessanter waren die praktischen Beiträge zu Data Science die eine Menge Fragen beantworteten:

- Wie kommt man überhaupt an Daten heran?

- Wie extrahiert man diese aus unterschiedlichen Datenbeständen?

- Wie lassen sich diese Daten kombinieren und wieder zu neuen Informationen verarbeiten

- Welche Tools zur Arbeit mit Daten gibt es?

- Welche rechtlichen Fragen muss man sich stellen?

Den ersten Talk – Street Fighting Data Science, der leider nicht aufgezeichnet wurde, bestritten Benedikt Köhler und Jörg Blumtritt. Allerdings gibt es die Folien zum Vortrag bei Slideshare. Die beiden brachten eine Menge Beispiele wie man mit sehr einfachen, improvisierten Tools Daten auseinander klamüsern kann, um daraus Erkenntnisse zu ziehen oder Visualisierungen zu bauen wie zum Beispiel Fotos nach Farben zu analysieren und in Kontext mit der Jahreszeit zu bringen oder mit dem passiven Wahlomat die Volltexte von Wahlprogrammen analysieren.

Außerdem habe ich in dem Talk Luca Hammer endlich mal persönlich kennen lernen dürfen, der aktuell an Blognetz seiner Visualisierung der deutschen Blogger-Szene arbeitet und habe von ihm einige Path-Aufkleber abgestaubt 🙂

Datenbefreiung selbst gemacht waren dafür 3 Vorträge in einem. Mit Sebastian Vollnhals, Jens Ohlig, Michael Kreil

Weitere Talks zum Thema Daten waren: Open Data & Culture von Joris Praekel und Daniel Dietrich (beide Open Knowledge Foundation), die Frage nach Personal Data – Nothing to hide? stellten sich Katarzyna Szymielewicz und Jérémie Zimmermann und dann gabe es noch die Data Cuisine – How to get juicy data from spreadsheets mit Anna Lena Schiller, Sylke Gruhrwald und Lisa Rienemann. Die Frage Open Data: Und was hat das mit mir zu tun? wurde von Julia Kloiber und Stefan Wehrmeyer gestellt.

Der witzigste und gleichzeitig nachdenklichste Vortrag: Die Digital Natives ziehen in den Krieg

Der Vortragstitel, der mich am meisten in die Irre geführt hat. Ich dachte zunächst es geht um Digital Natives, die gegen einen großen Konzern oder eine Ungerechtigkeit Aktionen starten. Weit gefehlt!

Digital Natives sind die Menschen, die sich an eine Zeit vor dem Internet nicht erinnern können, weil sie bereits ins Internetzeitalter geboren wurden. Junge Soldatinnen sind natürlich ebenfalls Digital Natives. Was machen also Soldaten und Soldatinnen wenn sie in den Einsatz ziehen und aus Krisengebieten oder ihrer Freizeit per Facebook, Twitter, YouTube berichten? Journalist Thomas Wiegold der u.a. über die Streitkräfte bloggt (Augen geradeaus) und Sascha Stoltenow – ein ehemaliger Bundeswehr-Offizier, der nun als PR-Berater arbeitet, haben einige witzige, spannende und nachdenklich stimmende Beiträge vorgestellt und erklärt.

Und weil dieser Talk so unglaublich gut war – hier das Video, die Präsentations-Folien und ein Behind-the-Scenes-Beitrag von Thomas.

[iframe src=“http://player.vimeo.com/video/65905002″ width=“500″ height=“281″ frameborder=“0″ webkitAllowFullScreen mozallowfullscreen allowFullScreen]

Die Digital Natives ziehen in den Krieg from Sascha Stoltenow on Vimeo

Die Digital Natives ziehen in den Krieg from Sascha Stoltenow on Vimeo

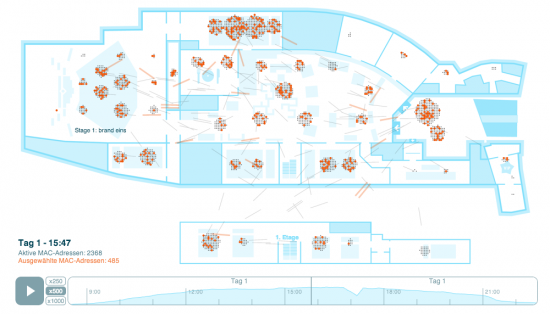

Die abgefahrenste Open Data Analyse bisher: Besucherströme der re:publica

Man nehme 5000 Konferenzbesucher, viele WLAN-Router und speichere deren Logdateien. Danach lassen sich die Bewegungsdaten durch die Säle anhand der Telefone je WLAN Router visualisieren. Un.Glaub.Lich:

Zur re:log-Website. Realisiert von OpenDataCity. Unterstützt durch picocell und newthinking. Anwendung steht unter CC-BY 3.0.

Besonderheiten dieser re:publica

- Das schnellste E-Book der Welt. Jeden Tag wurde eine gut 200-seitige zusammenfassung des Vortages als e-book veröffentlicht.

- 8500 Würfel aus Pappe als Gestaltungselemente, Raumtrenner und Standwände.

- Schlangen vor den Damentoiletten

- Viele Kinder auf der Konferenz (bemerkt von Thomas Knüwer)

- Über 5500 Telefone und in keinem Vortrag klingelte eines!

- Und natürlich die Plakate der letzten 100 Jahre Re:Publica 🙂

Interessante Vorträge im Schnelldurchgang

Eine vollständige Wiedergabe einer solchen Mammutveranstaltung ist nur schwer möglich. Deswegen bleibe ich bei einigen Highlights, die ich erst nachher in den Videoaufzeichnungen entdeckt habe.

- Die Geschichte des Computers mit Horst Zuse, dem Sohn vom Erfinder des Computers Konrad Zuse

- Innovating Africa Erik Hersman berichtet über beeindruckende Startups aus Afrika

- Kaleb Lechowski spricht über seinen Kurzfilm R’ha mit über 3 Millionen Views

- Digital Labor – Trebor Scholz spricht über digitale Zeitarbeit

- Neil Harbisson, der erste offiziell anerkannte Cyborg erzählt aus seinem Leben

- Fast schon Poetry Slam zu Kinder und dem Netz von Tanja und Johnny Haeusler

- Mein Beitrag als Bielefelder im Vortrag zu Verschwörungstheorien

- Was hat #Aufschrei gebracht? Anne Wizorek hat es in ihrem Talk erklärt

Andere Stimmen zur re:publica:

- einen schönen Kurzrückblick auf ihre erste re:publica gibt Kristine Honig

- Podcasts satt gab es von Die-Sondersendung aus dem Re:Publica-Studio

- netzkombyse hat u.a. diese Zahlen gesammelt: 64.000 Tweets 1,7 Terrabyte übertragene Daten & 13.000 Flaschen Bier & 5.500 Flaschen Club Mate

- Oliver Gassner auf dem eigenen Blog bloggte er live und wirft auf CHIP.de einen Blick aus Business-Sicht auf die re:publica

- Thomas Knüwer hat wie jedes Jahr eine der wunderbarsten Zusammenfassung geschrieben

- Im Beitrag Leben in medialen Paralleluniversen wird wunderbar zwischen der re:publica Avantgarde und dem Medientreffpunkt Mitteldeutschland gependelt

- Die eher kritisch und berechtigte Beleuchtung der #rp13 gibt es bi tante.cc

- Christina Jahn erklärt auf LewisPR, warum sich die Re-Publica auch für PRler lohnt

- Für das Foto-Startup pixoona war es ein Klassentreffen mit eigener Busrundfahrt bei

- projecter hat man genau die Vorträge besucht, die ich auch gerne gesehen hätte, die aber leider mit der Vorauswahl kollidierten

- kleinerdrei hat alle drei Tage der #rp13 zusammengefasst 1, 2, 3

- Selbst der Musikexpress war vor Ort – v.a. natürlich wegen der Urheberrechts-Thematik

- Gilly (den ich nicht Gilly alle nennen darf *g*) hat u.a. seine Lieblings-Tweets der R:P gesammelt

- Michael Kreil hat eine graphische Oberfläche für die Videovorträge gebaut

- dailymo hat hier auch noch einmal seine Highlights zusammen gefasst.